Image par auteur

Pour beaucoup d’entre nous, explorer les possibilités des LLM semble hors de portée. Qu’il s’agisse de télécharger des logiciels complexes, de comprendre le codage ou d’avoir besoin de machines puissantes, se lancer dans les LLM peut sembler intimidant. Mais imaginez si nous pouvions interagir avec ces puissants modèles de langage aussi facilement que démarrer n’importe quel autre programme sur nos ordinateurs. Pas d’installation, pas de codage, il suffit de cliquer et de parler. Cette accessibilité est essentielle tant pour les développeurs que pour les utilisateurs finaux. llamaFile apparaît comme une nouvelle solution, fusionnant les appeler.cpp avec Libc cosmopolite dans un cadre unique. Ce cadre réduit la complexité des LLM en offrant un exécutable à un seul fichier appelé « fichier lama »qui s’exécute sur des machines locales sans nécessiter d’installation.

Alors, comment ça marche? offres lamaFile deux méthodes pratiques pour exécuter des LLM :

- La première méthode consiste à télécharger la dernière version de lamafile ainsi que les poids de modèle correspondants depuis Hugging Face. Une fois que vous avez ces fichiers, vous êtes prêt à partir !

- La deuxième méthode est encore plus simple : vous pouvez accéder exemples de fichiers lama préexistants qui ont des poids intégrés.

Dans ce tutoriel, vous travaillerez avec le fichier lama du modèle LLaVa en utilisant la deuxième méthode. Il s’agit d’un modèle de 7 milliards de paramètres quantifiés sur 4 bits avec lequel vous pouvez interagir via le chat, télécharger des images et poser des questions. Les exemples de fichiers lama d’autres modèles sont également disponibles, mais nous travaillerons avec le modèle LLaVa car sa taille de fichier lama est de 3,97 Go, tandis que Windows a une taille de fichier exécutable maximale de 4 Go. Le processus est assez simple et vous pouvez exécuter des LLM en suivant les étapes mentionnées ci-dessous.

Tout d’abord, vous devez télécharger l’exécutable lllava-v1.5-7b-q4.llama (3,97 Go) à partir de la source fournie. ici.

Ouvrez le terminal de votre ordinateur et accédez au répertoire où se trouve le fichier. Exécutez ensuite la commande suivante pour accorder à votre ordinateur l’autorisation d’exécuter ce fichier.

chmod +x llava-v1.5-7b-q4.llamafileSi vous êtes sous Windows, ajoutez « .exe » au nom du fichier lama à la fin. Vous pouvez exécuter la commande suivante sur le terminal à cet effet.

rename llava-v1.5-7b-q4.llamafile llava-v1.5-7b-q4.llamafile.exeExécutez le fichier lama par la commande suivante.

./llava-v1.5-7b-q4.llamafile -ngl 9999⚠️ Puisque MacOS utilise zsh comme shell par défaut et si vous rencontrez zsh: exec format error: ./llava-v1.5-7b-q4.llamafile erreur alors vous devez exécuter ceci :

bash -c ./llava-v1.5-7b-q4.llamafile -ngl 9999Pour Windows, votre commande peut ressembler à ceci :

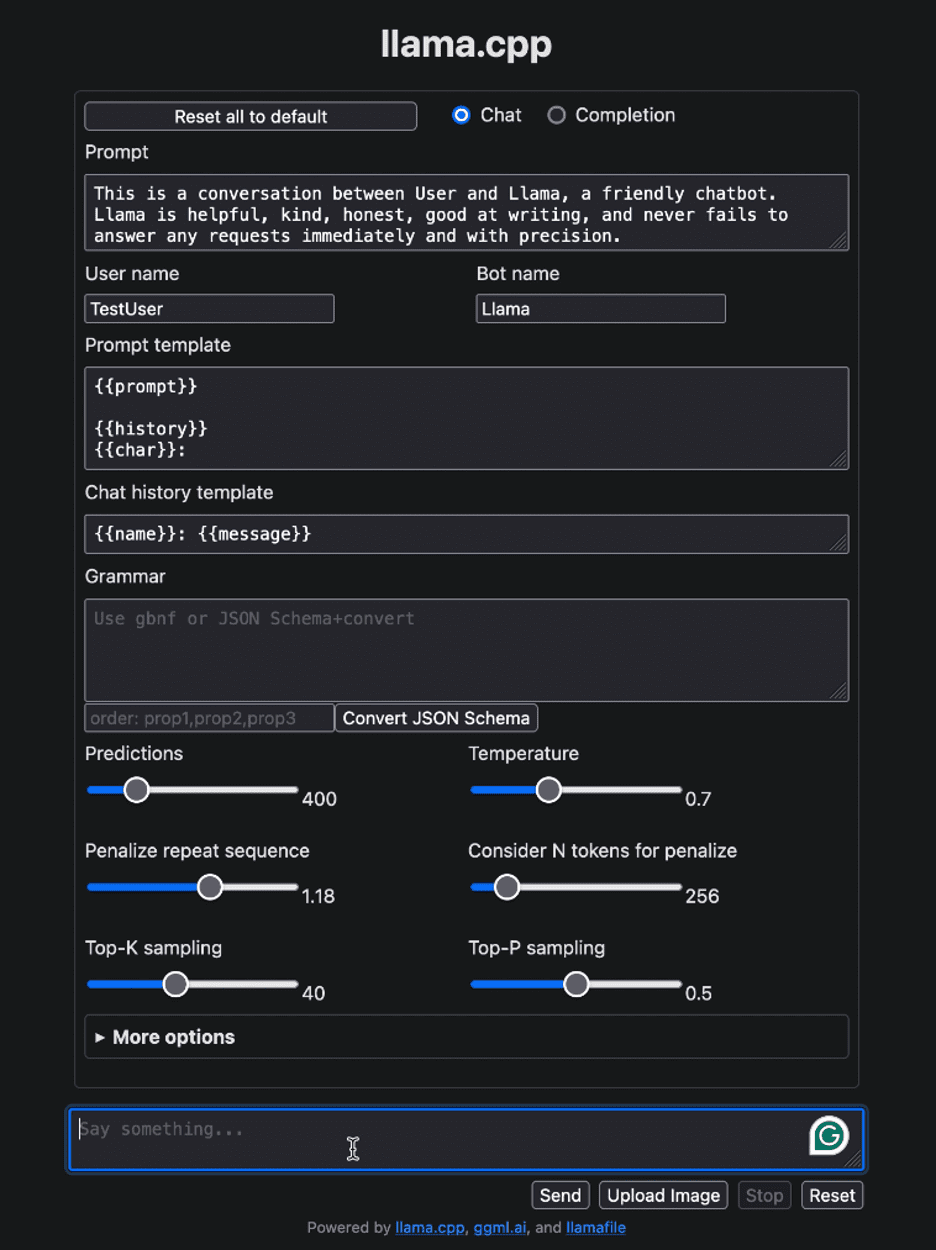

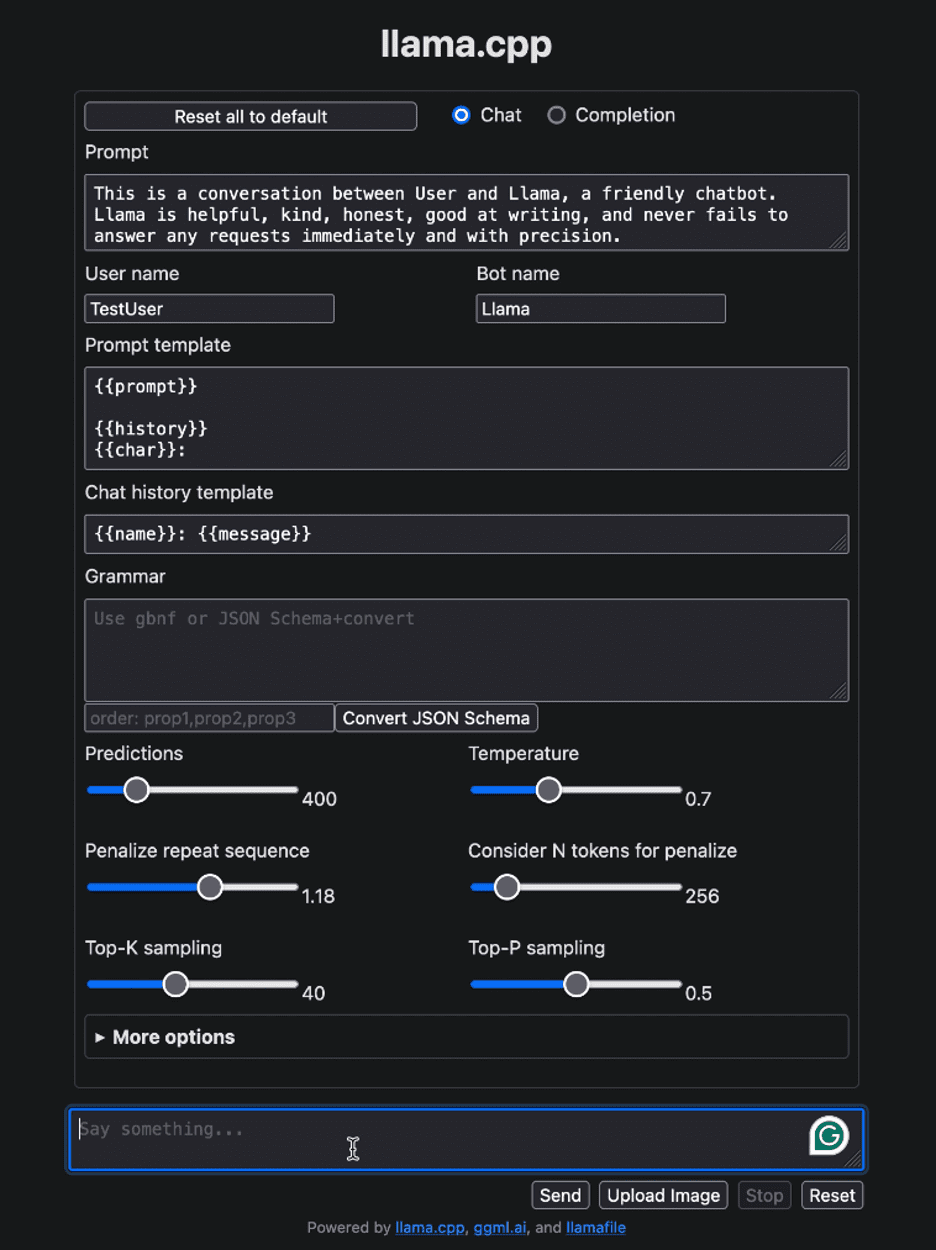

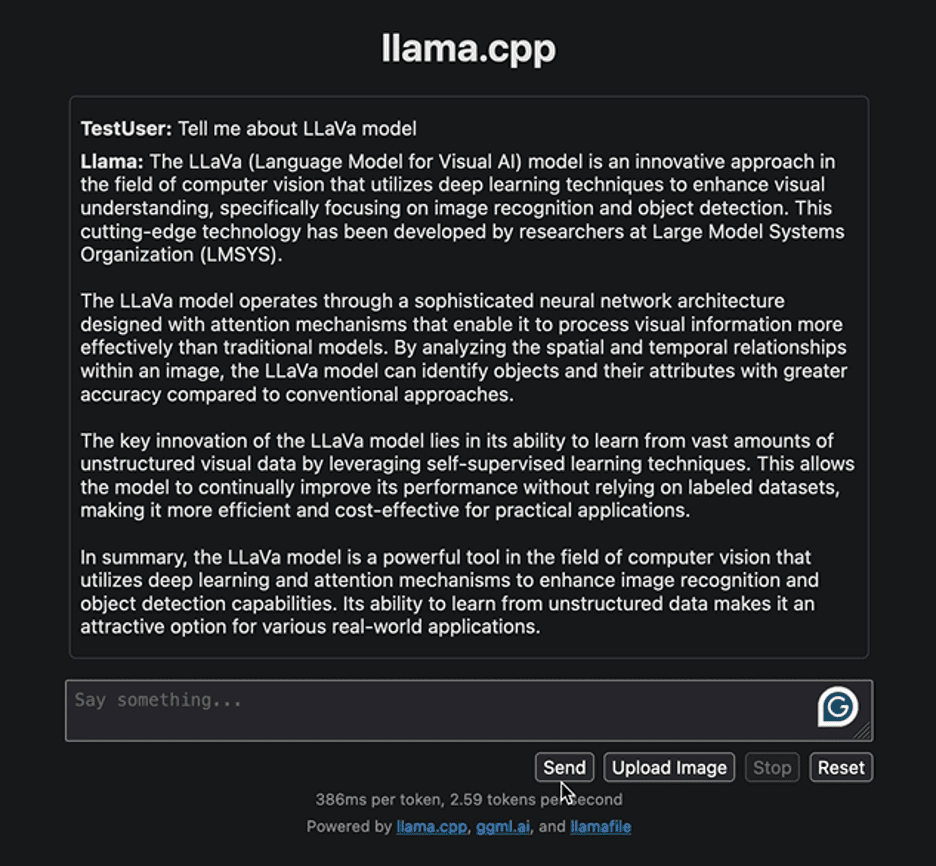

llava-v1.5-7b-q4.llamafile.exe -ngl 9999Après avoir exécuté le fichier lama, il devrait automatiquement ouvrir votre navigateur par défaut et afficher l’interface utilisateur comme indiqué ci-dessous. Si ce n’est pas le cas, ouvrez le navigateur et accédez à http://localhost:8080 manuellement.

Image par auteur

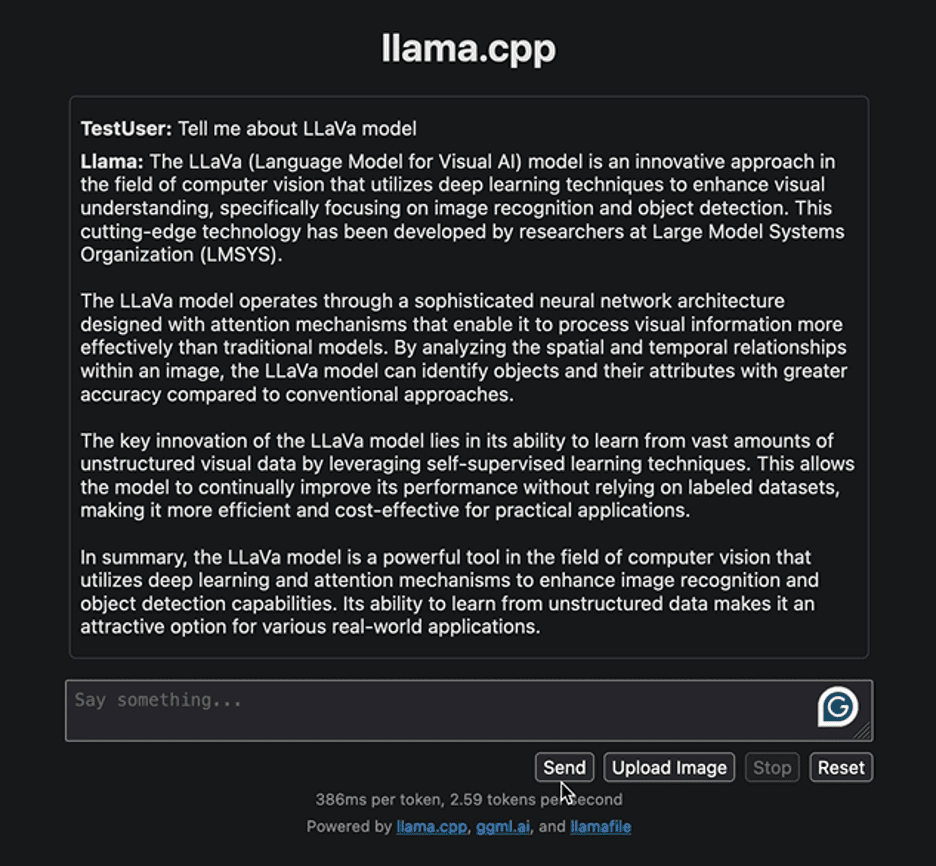

Commençons par interagir avec l’interface avec une question simple pour fournir quelques informations liées au modèle LLaVa. Ci-dessous la réponse générée par le modèle :

Image par auteur

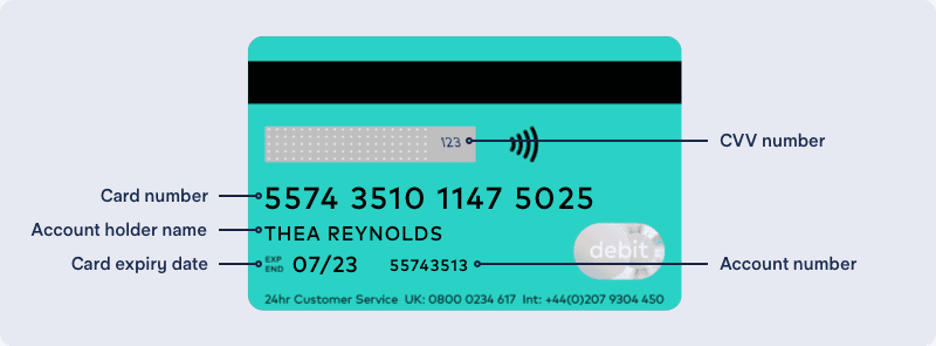

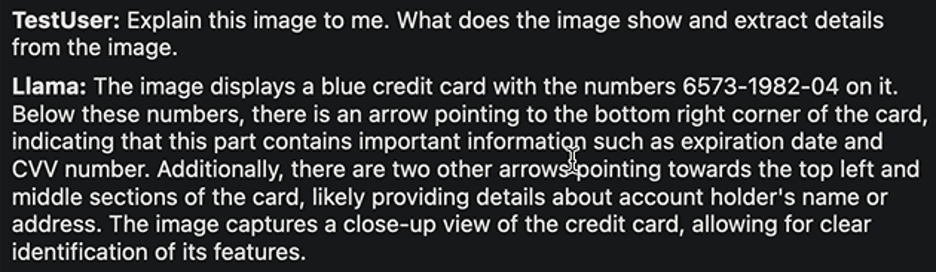

La réponse met en évidence l’approche de développement du modèle LLaVa et ses applications. La réponse générée a été raisonnablement rapide. Essayons de mettre en œuvre une autre tâche. Nous allons télécharger l’exemple d’image suivant d’une carte bancaire avec des détails dessus et en extraire les informations requises.

Image de Ruby Thompson

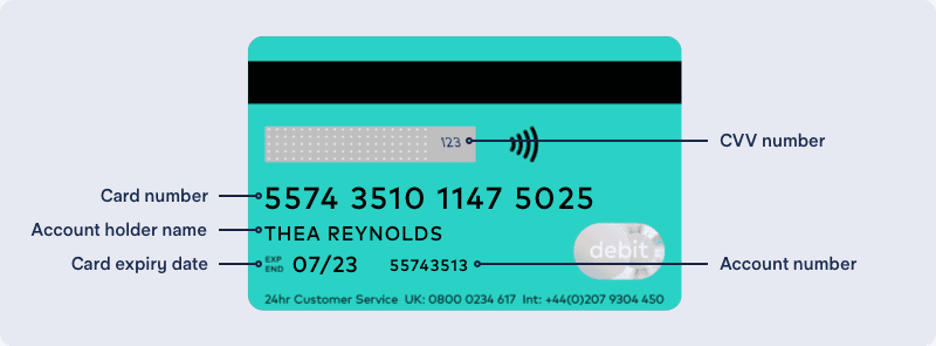

Voici la réponse :

Image par auteur

Encore une fois, la réponse est assez raisonnable. Les auteurs de LLaVa affirment qu’il atteint des performances de premier ordre dans diverses tâches. N’hésitez pas à explorer diverses tâches, à observer leurs succès et leurs limites, et à découvrir vous-même les performances exceptionnelles de LLaVa.

Une fois votre interaction avec le LLM terminée, vous pouvez arrêter le fichier lama en revenant au terminal et en appuyant sur « Contrôle – C ».

Distribuer et exécuter des LLM n’a jamais été aussi simple. Dans ce didacticiel, nous avons expliqué avec quelle facilité vous pouvez exécuter et expérimenter différents modèles avec un seul fichier lama exécutable. Cela permet non seulement d’économiser du temps et des ressources, mais élargit également l’accessibilité et l’utilité réelle des LLM. Nous espérons que vous avez trouvé ce didacticiel utile et aimerions connaître votre avis à ce sujet. De plus, si vous avez des questions ou des commentaires, n’hésitez pas à nous contacter. Nous sommes toujours heureux de vous aider et d’apprécier votre contribution.

Merci pour la lecture!

Kanwal Mehreen Kanwal est un ingénieur en apprentissage automatique et un rédacteur technique passionné par la science des données et l’intersection de l’IA et de la médecine. Elle a co-écrit l’ebook « Maximiser la productivité avec ChatGPT ». En tant que Google Generation Scholar 2022 pour l’APAC, elle défend la diversité et l’excellence académique. Elle est également reconnue comme boursière Teradata Diversity in Tech, boursière de recherche Mitacs Globalink et boursière Harvard WeCode. Kanwal est un ardent défenseur du changement, ayant fondé FEMCodes pour autonomiser les femmes dans les domaines STEM.