Dans une série d’entretiens, nous rencontrons certains des Consortium doctoral AAAI/SIGAI participants d’en savoir plus sur leurs recherches. Le Consortium doctoral offre à un groupe de doctorants la possibilité de discuter et d’explorer leurs intérêts de recherche et leurs objectifs de carrière dans le cadre d’un atelier interdisciplinaire avec un panel de chercheurs confirmés. Dans cette dernière interview, nous avons rencontré Balint Gyevnár et découvert son travail de création d’explications pour les systèmes de prise de décision basés sur l’IA.

Parlez-nous un peu de votre doctorat : où étudiez-vous et quel est le sujet de votre recherche ?

Je suis doctorant et j’approche la fin de ma troisième année ici à l’Université d’Édimbourg. J’ai eu la chance d’étudier dans cette université pendant les huit dernières années, j’y ai donc également effectué mes études de premier cycle et de maîtrise. J’apprécie vraiment Édimbourg – c’est un environnement très stimulant et il y a beaucoup de discussions académiques qui m’ont incité à rester ici. J’ai en fait trois superviseurs : Stefano Albrecht, Chris Lucas et Shay Cohen. Stefano travaille dans l’apprentissage par renforcement et les systèmes multi-agents, il dirige le groupe de recherche sur les agents autonomes. Chris est un spécialiste des sciences cognitives qui s’intéresse à la manière dont les gens expliquent et déduisent des explications sur le monde. Shay s’intéresse au traitement du langage naturel. Mes recherches se situent à l’intersection de ces trois domaines. Si je devais utiliser un terme générique pour décrire ce sur quoi je travaille, je dirais que je travaille sur l’IA explicable. Plus précisément, j’essaie de créer des explications pour les systèmes de prise de décision basés sur l’IA d’une manière qui soit accessible à quelqu’un qui n’est pas impliqué dans l’IA. J’examine des systèmes de prise de décision séquentiels qui doivent décider quoi faire étape par étape et doivent interagir avec leur environnement de diverses manières intéressantes.

De nombreux systèmes d’IA limitent aujourd’hui la liberté de décision dont disposaient auparavant les individus. Sans avoir la compréhension nécessaire du fonctionnement de ces systèmes et sans avoir une idée de ce qu’ils font, il est presque impossible de découvrir ce qui ne va pas lorsqu’il y a un problème avec cette prise de décision. Cela a des implications sur la façon dont nous jugeons la sécurité des systèmes, sur la façon dont nous les traitons et sur leur perception du public. La motivation globale de mon travail est donc réellement d’essayer d’améliorer la transparence de ces systèmes en leur conférant une capacité à donner des explications.

Y a-t-il un projet en particulier qui a été vraiment intéressant ?

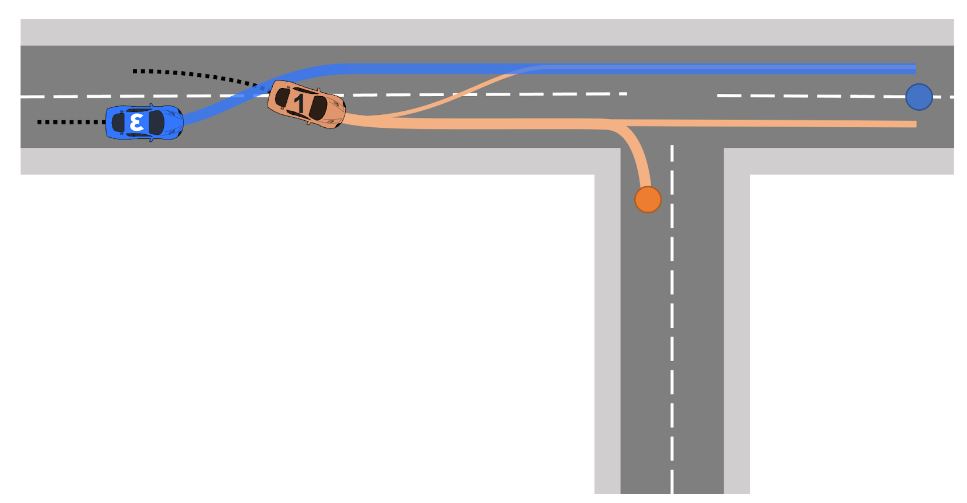

Le travail le plus récent que j’ai réalisé a récemment été accepté au Conférence sur les agents autonomes et les systèmes multi-agents (AAMAS). Je travaillais avec des véhicules autonomes. Nous avons eu ces scénarios dans lesquels des véhicules autonomes interagissent avec d’autres véhicules dans l’environnement. Et nous avons essayé d’expliquer comment et pourquoi ils se comportaient d’une certaine manière.

Figure 1. Dans ce scénario, le véhicule orange coupe devant la voiture bleue autonome qui doit réagir à ce comportement de manière sûre et efficace. Les actions entreprises pourraient inciter les gens à se poser des questions sur les raisons pour lesquelles il a fait cela et nous devons y répondre de manière intelligible et claire.

Figure 1. Dans ce scénario, le véhicule orange coupe devant la voiture bleue autonome qui doit réagir à ce comportement de manière sûre et efficace. Les actions entreprises pourraient inciter les gens à se poser des questions sur les raisons pour lesquelles il a fait cela et nous devons y répondre de manière intelligible et claire.

À titre d’exemple, imaginez que vous conduisez sur une route à deux voies, qu’un carrefour en T arrive et que quelqu’un coupe devant vous, puis commence à ralentir. Ce que nous observerions un véhicule autonome, par exemple, c’est changer de voie, afin de pouvoir dépasser le véhicule qui vient de passer devant lui. La seule question que pourrait se poser la personne assise dans la voiture lorsqu’elle remarque ce genre de comportement est de se demander pourquoi la voiture a agi ainsi. Ce que de nombreux systèmes d’IA explicables actuels donnent comme explication n’est pas nécessairement utile. Ils pourraient dire quelque chose comme « nous avons changé de voie parce que les caractéristiques X, Y et Z avaient une importance de 5,2 à 3,5, 15,6 ». Ce sont des nombres complètement arbitraires, mais ce que j’essaie d’illustrer ici, c’est qu’ils ont ces caractéristiques, c’est-à-dire la distance parcourue par le véhicule qui vous précède, la vitesse à laquelle le véhicule qui vous précède se déplace, etc., puis ils les commandent d’une manière ou d’une autre. cela ne dit pas grand-chose sur l’impact de ces fonctionnalités sur la décision du système. Un système complexe aurait des milliers de ces fonctionnalités, et il vous donnerait simplement un classement de celles qui ont contribué à la décision. Si vous donniez cette explication à quelqu’un, cela ne servirait à rien.

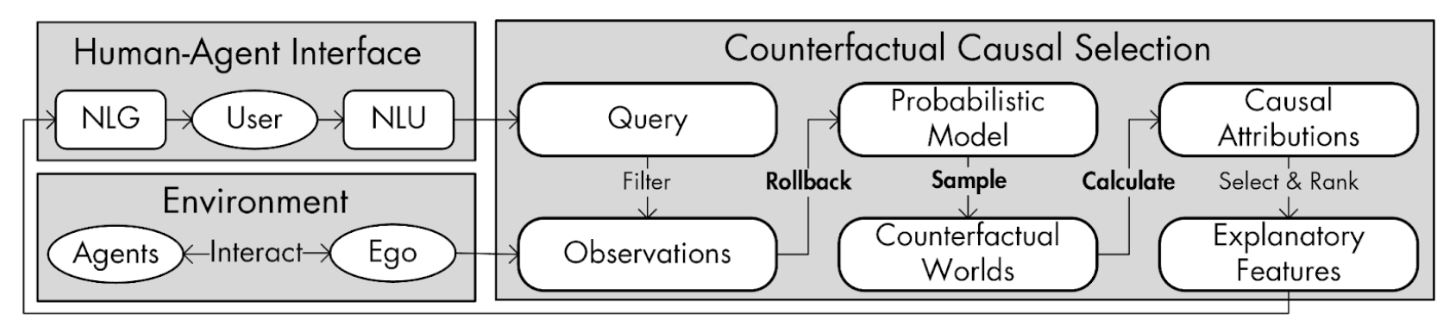

Figure 2. Notre système de génération d’explications causales proposé appelé CEMA peut créer des explications intelligibles dans un cadre conversationnel aux requêtes des utilisateurs sur tout système autonome multi-agents.

Figure 2. Notre système de génération d’explications causales proposé appelé CEMA peut créer des explications intelligibles dans un cadre conversationnel aux requêtes des utilisateurs sur tout système autonome multi-agents.

Au lieu de cela, nous aimerions leur donner des explications causales, ce qui signifie donner l’explication en termes de relation de cause à effet. Donc, ce qu’on pourrait dire, c’est « nous avons changé de voie parce que le véhicule qui nous précédait est entré en collision ». Vous pouvez également développer cela, et c’est un élément essentiel de ce que je fais. Vous pouvez avoir cette conversation avec l’utilisateur où vous pourrez affiner l’explication étape par étape. Et puis, s’ils demandent « OK, mais pourquoi changeriez-vous de voie simplement parce qu’ils ont coupé devant nous ? », l’explication pourrait dire « ils nous auraient ralentis parce qu’ils tournaient probablement à droite » ou « c’était dangereux ». parce qu’ils étaient trop près de nous, donc pour être plus en sécurité et maintenir nos distances, nous avons simplement tourné à gauche ». Nous soutenons que ce type d’explications est plus propice à améliorer la compréhension des gens sur la manière dont ce système a réellement pris ces décisions. Ce que je trouve vraiment cool, c’est que le système que nous proposons est en réalité indépendant du système d’IA que vous utilisez.

Sur quoi comptez-vous travailler ensuite ?

Une idée potentielle que nous avons étudiée est de vraiment se concentrer sur cet aspect conversationnel et d’affiner les objectifs d’explication avec l’utilisateur. Cela impliquerait d’emmener les gens au bureau et de les déposer devant un ordinateur et de les amener à discuter avec le système et à voir comment ils se comportent. Il s’agirait davantage d’une analyse liée à l’interaction homme-agent, plutôt que de se concentrer uniquement sur l’aspect informatique, ce que font beaucoup de gens dans l’IA explicable : ils ignorent les parties prenantes et ne se concentrent pas sur l’aspect convivialité.

Je voulais poser des questions sur l’AAAI et le Consortium doctoral. Comment s’est passée l’expérience en général ?

C’était la première fois que j’assistais à une conférence d’une telle envergure et j’ai vraiment apprécié. J’ai trouvé que les interactions avec les gens étaient vraiment stimulantes, même si c’était aussi super fatigant car le programme allait de 8h30 à 21h00, donc c’étaient de longues journées. Spécifiquement pour le consortium doctoral, j’ai constaté qu’il y avait beaucoup de personnes travaillant dans des domaines similaires aux miens. Et sans avoir jamais parlé à ces personnes, il existe un sentiment croissant qui soutient les idées que je défends également, le genre de création d’explications plus orientées et centrées sur l’humain pour les systèmes d’IA. Cela semble être un sujet de plus en plus populaire, et je l’ai également constaté au sein du consortium doctoral. L’interaction avec les autres étudiants était vraiment intéressante. J’ai vu des travaux vraiment sympas sur lesquels je lis davantage, et j’espère en voir davantage de la part de ces personnes à l’avenir. La séance d’affiches était également bonne.

Nous avons également eu une conférence intéressante du professeur Peter Stone, sur les discussions sur les emplois universitaires. J’ai trouvé cela très utile car j’en arrive au point où je dois penser à mon avenir. Voir le déroulement du processus de recrutement universitaire a été instructif et m’aidera à formuler davantage mes décisions à l’avenir. Il y a une diapositive particulière dans le discours de Peter qui a retenu mon attention. Il a dit que votre exposé sur le travail devrait être accessible à tout le monde, même à ceux qui n’ont pas la compréhension nécessaire pour comprendre clairement les détails techniques de votre travail, à l’exception d’une diapositive où vous devriez perdre tout le monde pour avoir l’air intelligent !

Qu’est-ce qui vous a donné envie d’étudier l’IA, et de vous lancer dans ce domaine en particulier ?

Eh bien, je me suis intéressé à l’apprentissage automatique en 2017. Ma première exposition a été de suivre le cours d’apprentissage profond d’Andrew Ng sur Coursera, qui à l’époque était beaucoup plus petit et beaucoup moins étoffé. Ensuite, j’ai effectué un stage dans une entreprise de voitures autonomes ici à Édimbourg. C’était pendant la COVID, donc tout se faisait à distance – malheureusement, je n’ai jamais pu voir le bureau. Mais nous travaillions là-bas sur un article qui est directement lié à ce que je fais, et j’ai vraiment apprécié l’atmosphère de collaboration et la pensée critique où les gens étaient ouverts au partage de points de vue. Je n’avais pas l’impression de devoir cacher mes opinions à mon superviseur si j’étais en désaccord avec quelque chose. Il n’y avait pas de politique toxique sur le lieu de travail. Donc, je pense que cela m’a vraiment séduit. De plus, tout le processus de rédaction de l’article, de réalisation des expériences et d’obtention de l’acceptation a abouti à la décision d’essayer de poursuivre un doctorat. J’ai vraiment apprécié le genre de vie académique que j’ai vécue lors de ce stage. Et puis, lorsque je faisais mon master à Édimbourg, j’avais de bonnes relations avec mon superviseur et nous avons donc décidé de le prolonger de quatre ans supplémentaires. [by doing the PhD]. C’est un programme de quatre ans car je fais partie du programme du Centre de Formation Doctorale (CDT).

Si vous deviez donner quelques conseils à des doctorants potentiels, que diriez-vous de faire un doctorat ?

Je dirais qu’il faut vraiment essayer de trouver quelque chose qu’ils trouvent vraiment intéressant et essayer de trouver un superviseur quelque part dans le monde qui s’intéresse à la même chose. Ce que j’ai découvert, c’est que les gens regardent souvent les noms des superviseurs et le nombre de publications, et recherchent un superviseur éminent. Ils ne se soucient peut-être pas de ce domaine, mais ils veulent simplement travailler avec la personne. Parfois, cela peut fonctionner. Mais s’il y a quelque chose qui vous passionne vraiment, vous devriez vous concentrer là-dessus. Rédigez une très bonne proposition de recherche qui montre votre enthousiasme pour cela et trouvez une personne qui correspond à vos intérêts.

Pourriez-vous nous raconter un fait intéressant à votre sujet ?

Je joue du piano très sérieusement. J’avais l’habitude de participer à des compétitions dans mon pays d’origine, la Hongrie. Je joue encore beaucoup et je trouve que jouer de la musique est un très bon moyen d’évacuer un peu de stress de sa vie et de se distraire du « monde réel ». Vous pouvez entrer dans cet espace magique où vous pouvez explorer les harmonies et je pense que c’est vraiment beau et j’ai l’intention de continuer ainsi.

À propos de Balint

| Balint Gyevnár est un étudiant de doctorat en avant-dernière année à l’Université d’Édimbourg, supervisé par Stefano Albrecht, Shay Cohen et Chris Lucas. Il se concentre sur la création de technologies d’IA explicables socialement alignées pour les utilisateurs finaux, en s’appuyant sur des recherches dans plusieurs disciplines, notamment les systèmes autonomes, les sciences cognitives, le traitement du langage naturel et le droit. Son objectif est de créer des systèmes autonomes plus sûrs et plus fiables que chacun peut utiliser et faire confiance de manière appropriée, quelle que soit sa connaissance des systèmes d’IA. Il est l’auteur ou le co-auteur de plusieurs ouvrages lors de conférences de haut niveau telles que l’ECAI, l’AAMAS, l’ICRA et l’IROS, et a reçu plusieurs prix de recherche en début de carrière de Stanford, UK Research and Innovation et IEEE Intelligent Transportation Systems Society. |

Mots clés: AAAI, Consortium doctoral AAAI, AAAI2024, ACM SIGAI

Lucy Smith, rédactrice en chef d’AIhub.