Rylan Schaeffer, Brando Miranda et Sanmi Koyejo ont remporté un prix NeurIPS 2023 pour leur travail exceptionnel Les capacités émergentes des grands modèles linguistiques sont-elles un mirage ?. Dans leur article, ils présentent une explication alternative des capacités émergentes dans les grands modèles de langage. Nous avons parlé à Brando de ce travail, de leur théorie alternative et de ce qui l’a inspiré.

Tout d’abord, pourriez-vous définir ce qu’est l’émergence et ce qu’elle signifie dans le contexte de grands modèles de langage ?

C’est une bonne question à laquelle il est difficile de répondre clairement, car le mot émergence existe dans la science depuis un certain temps. Par exemple, en physique, lorsque vous atteignez un certain nombre d’atomes d’uranium, vous pouvez fabriquer une bombe, mais avec moins, vous ne pouvez pas.

Il existe différentes définitions de l’émergence, mais je pense qu’il serait utile de dire comment nous la définissons dans notre travail. Il s’agit essentiellement d’un saut imprévisible et brutal dans une métrique à mesure qu’un paramètre de complexité augmente, généralement le nombre de paramètres. Dans le contexte de grands modèles de langage, cela signifie que le modèle en question passe apparemment d’incompétent à vraiment bon dans quelque chose.

C’est ce que nous avons étudié dans notre travail, et nous avons montré essentiellement que le saut est une fonction importante de la métrique, c’est-à-dire de la manière dont vous évaluez les performances du modèle.

Dans votre article, vous remettez en question l’affirmation selon laquelle les LLM possèdent des capacités émergentes. Qu’est-ce qui vous a poussé à vouloir approfondir cette question ? Quelle a été la source de votre doute initial ?

Je suis une personne assez sceptique et j’aime beaucoup bien comprendre les choses. J’ai eu la chance de travailler avec Rylan (qui était dans mon laboratoire en rotation et qui devrait être reconnu pour l’idée et les tests) et Samni, et nos personnalités ont parfaitement fonctionné pour faire ce genre de recherche. Rylan et moi avions tous deux réfléchi à ce problème et, à travers nos conversations, nous avons convergé vers cette direction de recherche. À mesure que les preuves devenaient plus solides, nous les avons approfondies. Il s’agissait d’un processus itératif, nous avions plusieurs hypothèses et la raison pour laquelle nous avons publié ce document est que nous étions efficaces dans l’itération sur un sous-ensemble d’entre elles.

Nous suivions également un cours, et les professeurs parlaient des capacités émergentes et il y avait beaucoup d’échanges de questions – avec Rylan menant la discussion. Nous n’y croyions pas vraiment, je suppose. Nous n’étions pas satisfaits des réponses. Je n’ai jamais hésité à poser des questions, et maintenant que nous sommes étudiants diplômés, ce type de personnalité interrogatrice a porté ses fruits. Nous sommes également passionnés par la vérité.

Pourriez-vous parler un peu de votre modèle ?

Le modèle est en fait super simple. Nous nous sommes assis et avons écrit ce que signifie la précision et, en supposant des lois d’échelle (à mesure que le modèle grandit, l’entropie croisée diminue), nous avons découvert que, pour un seul jeton, vous pourriez avoir une équation de forme fermée si la séquence était de longueur 1. En d’autres termes, on pourrait dire que la précision est égale à l’exponentielle de l’entropie croisée négative. Le modèle suggère que ces sauts brusques et imprévisibles se produiront naturellement en raison de l’exponentielle.

Le cas de longueur L > 1 est l’un des cas les plus importants et celui que nous soulignons et étudions en profondeur dans cet article. Cependant, j’ai personnellement trouvé fascinant que même pour une longueur L=1, la précision puisse être modélisée par une fonction exponentielle de la loi d’échelle/CE(N). En d’autres termes, le modèle mathématique suggère que des sauts nets et prévisibles se produisent même lorsque la longueur de la séquence est de 1. Ce que nous avons montré plus loin, c’est que dans le cas des LLM (ou des modèles qui génèrent des séquences), cela est exacerbé parce que vous Réduire encore plus quelque chose d’exponentiel en multipliant l’exponentielle plusieurs fois. Ainsi, pour une longueur 1, alors que vous devriez vous attendre à des sauts brusques et imprévisibles, pour une longueur > 1, cela devrait être encore pire. C’est ainsi que les gens utilisent les LLM dans la pratique. Cela signifie essentiellement que c’est une propriété intrinsèque de la métrique, ce que j’ai trouvé intéressant. Avec le recul, je suppose qu’il est plus facile d’y penser de cette façon, mais la précision donne essentiellement à votre modèle un score de 0 ou 1. Avec le recul, il est logique que la précision soit dure car il s’agit littéralement d’une fonction échelonnée. Des calculs très simples ont démontré que c’est probablement vrai.

Comment avez-vous procédé pour tester votre modèle ? Quelles expériences avez-vous réalisées ?

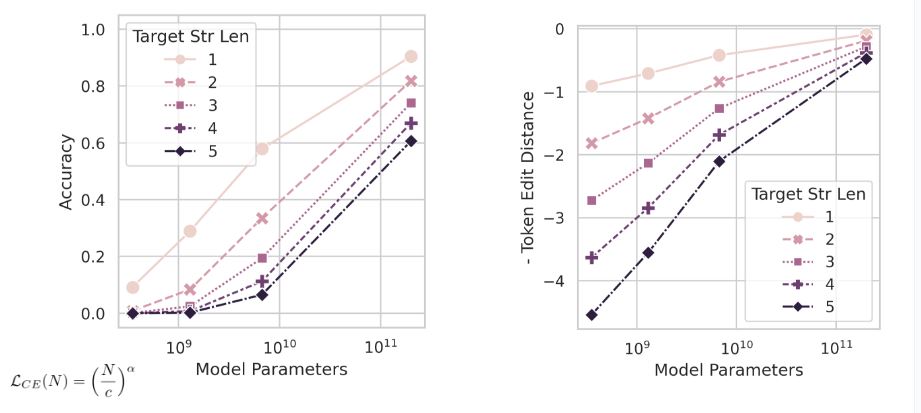

Une fois que nous avons obtenu une précision égale à l’exponentielle de l’entropie croisée négative en fonction du nombre de paramètres, nous avons obtenu des courbes de précision en fonction des paramètres. Le modèle est essentiellement une précision en fonction de paramètres. Nous avons donc tracé le modèle mathématique et nous pouvons voir comment les courbes de précision se comportent à mesure que le nombre de paramètres augmente. Nous avons aussi avoir plusieurs courbes pour montrer la dépendance en fonction de la longueur du modèle.

Nous avons commencé avec notre tracé mathématique et avons cherché si nous pouvions reproduire ce tracé pour le LLM. Et nous pourrions.

Exemple de tracé. Changer la métrique conduit à un tracé linéaire (au lieu des sauts brusques prétendument « émergence »).

Exemple de tracé. Changer la métrique conduit à un tracé linéaire (au lieu des sauts brusques prétendument « émergence »).

Dans l’article, vous mentionnez que vous avez induit des capacités apparemment émergentes dans diverses tâches de vision en modifiant intentionnellement les paramètres utilisés pour l’évaluation. Pourriez-vous en parler un peu ?

Fondamentalement, nous voulions insister sur le fait qu’en modifiant la métrique, vous pourriez accidentellement créer le tracé que vous souhaitiez, affichant des propriétés émergentes supposées. Lorsque nous avons expérimenté les auto-encodeurs, nous avons essayé d’imiter ce que faisaient les métriques utilisées pour évaluer les grands modèles de langage, mais pour la vision. Nous avions une tâche où il y avait un seuil où, une fois que vous aviez plus ou moins un certain nombre de pixels corrects, vous obteniez un score de un ou zéro, comme une fonction de seuil. C’était comme une expérience interventionnelle ; nous modifions une variable et nous montrons qu’elle provoque les changements.

C’est en fait une bonne façon de relier l’ensemble du papier. Ainsi, dans la première moitié de l’article, nous avons des LLM, nous montrons notre modèle mathématique et qu’il prédit la netteté. C’est ainsi que se comportent les modèles ; ils ont de la netteté. Nous testons également notre modèle mathématique pour des métriques douces (c’est-à-dire n’utilisant pas la précision) et montrons que les LLM semblent fluides et linéaires. Fondamentalement, nous avons testé dans le sens de dur à doux et avons montré que le saut brusque disparaissait.

Dans la deuxième partie du document, où nous parlons de vision, nous avons fait l’inverse. Il est intéressant de noter que dans la vision, il y a une sorte d’accord implicite selon lequel nous ne voyons pas de capacités émergentes. Maintenant que nous avions notre hypothèse, nous avons examiné les métriques qu’ils utilisaient et nous avons fait l’expérience inverse : des métriques douces aux métriques dures. Et nous avons pu « provoquer » des capacités émergentes.

Quels sont les messages clés que vous souhaitez que les gens retiennent de votre travail ?

Je pense qu’il est bon de savoir quelles mesures vous intéressent vraiment dans votre application, mais il est également très important de comprendre les compromis qu’elles impliquent. La précision est souvent la mesure que les gens souhaitent utiliser, mais soit ils ne disposent pas de suffisamment de données de test, soit il s’agit simplement d’une mesure intrinsèquement précise et instable et les gens ne le savent pas. Une bonne solution pourrait être que les gens proposent des mesures proches de ce qu’ils souhaitent, mais qui ne possèdent pas ces propriétés. De cette façon, nous pouvons au moins faire mieux en matière de science. C’est un message clé : soyez conscient des métriques et des compromis et ne soyez pas surpris si vous constatez des sauts brusques si votre métrique n’autorise le crédit que si vous obtenez la chaîne exacte, par exemple. Soyez prudent avec le processus d’évaluation que vous utilisez !

Il y a aussi une question philosophique plus profonde sur ce que signifie l’intelligence. La métrique et la tâche définissent implicitement ce que nous entendons par intelligence, ce que nous entendons par capacité. L’arithmétique, par exemple, est une tâche favorite pour tester des modèles, et le sentiment que si vous n’obtenez pas tous les chiffres correctement, vous n’avez pas réussi l’arithmétique. Mais ce n’est pas vraiment ainsi que nous évaluons les humains. Lorsque vous êtes au lycée et que vous oubliez d’en porter un, vous obtiendrez quand même des crédits. De nombreux examens sont divisés en parties pour accorder un crédit partiel, car nous ne prétendons pas qu’une personne ne sait pas faire des mathématiques si elle fait une erreur.

Certains travaux ont parfois tendance à être exagérément médiatisés, avec une revendication excessive des résultats. Je ne suis pas sûr que cela soit productif. J’espère que ce travail incitera les gens à être plus sceptiques quant à ce qu’ils voient rapporté.

En savoir plus

À propos de Brando

| Brando Miranda est actuellement titulaire d’un doctorat. Étudiant à l’Université de Stanford sous la direction du Professeur Sanmi Koyejo au Département d’Informatique de Stanford au sein du groupe de recherche STAIR (Safe and Trustworthy AI). Les intérêts de recherche de Miranda résident dans l’apprentissage automatique centré sur les données pour les modèles de base, le méta-apprentissage, l’apprentissage automatique pour la preuve de théorèmes et l’intelligence artificielle (IA) inspirée de l’homme et du cerveau. |

Mots clés: NeuroIPS, NeurIPS2023

Lucy Smith, rédactrice en chef d’AIhub.