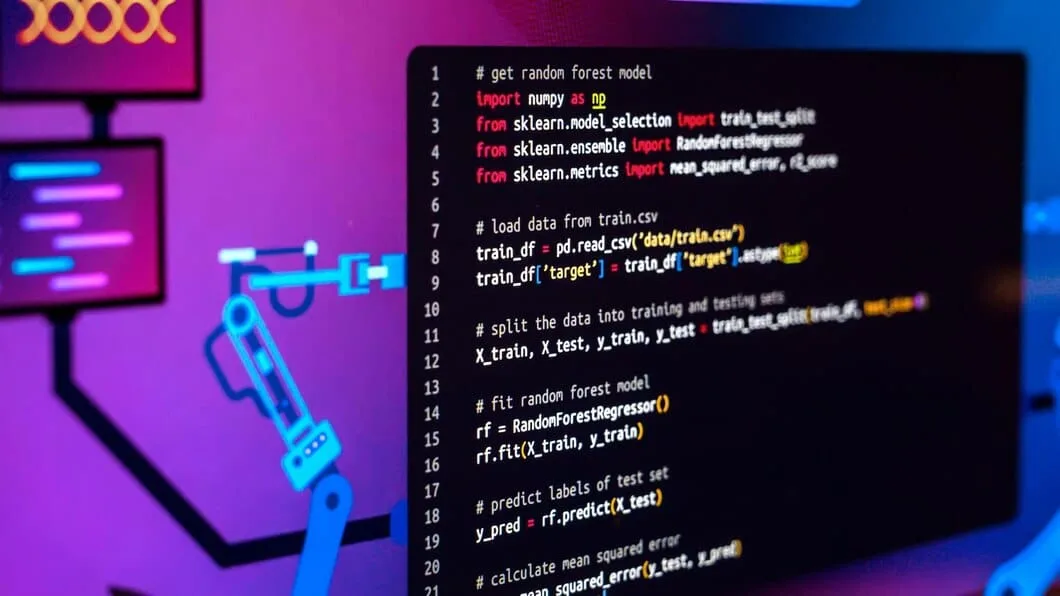

Image de Freepik

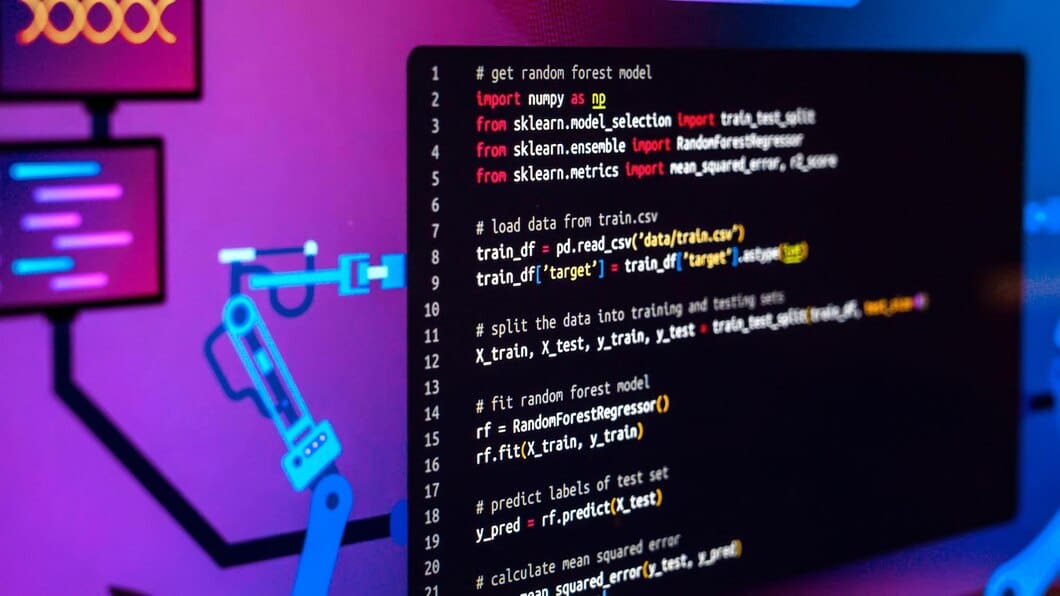

Python règne en maître dans le monde de la science des données, mais de nombreux data scientists en herbe (et même chevronnés) ne font qu’effleurer la surface de ses véritables capacités. Pour véritablement maîtriser l’analyse des données avec Python, vous devez vous aventurer au-delà des bases et utiliser des techniques avancées conçu pour une manipulation efficace des données, un traitement parallèle et l’exploitation de bibliothèques spécialisées.

Les ensembles de données volumineux et complexes et les tâches gourmandes en calcul que vous rencontrerez exigent plus que des compétences Python d’entrée de gamme.

Cet article sert de guide détaillé visant à améliorer vos compétences Python. Nous aborderons les techniques permettant d’accélérer votre code, utiliser Python avec de grands ensembles de données, et transformer les modèles en services Web. Tout au long, nous explorerons les moyens de gérer efficacement les problèmes de données complexes.

Maîtriser techniques Python avancées car la science des données est essentielle sur le marché du travail actuel. La plupart des entreprises ont besoin de data scientists qui maîtrisent Python. Django et Flask.

Ces composants rationalisent l’inclusion de fonctionnalités de sécurité clés, en particulier dans les niches adjacentes, telles que l’exécution Hébergement conforme PCIconstruire un Produit SaaS pour les paiements numériquesou même accepter des paiements sur un site Web.

Alors, qu’en est-il des mesures pratiques ? Voici quelques-unes des techniques que vous pouvez commencer à maîtriser dès maintenant :

Manipulation efficace des données avec Pandas

La manipulation efficace des données avec Pandas consiste à exploiter ses puissants objets DataFrame et Series pour gérer et analyser les données.

Pandas excelle dans des tâches telles que le filtrage, le regroupement et fusionner des ensembles de données, permettant des opérations complexes de manipulation de données avec un minimum de code. Sa fonctionnalité d’indexation, y compris l’indexation à plusieurs niveaux, permet une récupération et un découpage rapides des données, ce qui le rend idéal pour travailler avec de grands ensembles de données.

En plus, Intégration de Pandas avec d’autres analyses de données et les bibliothèques de visualisation de l’écosystème Python, telles que NumPy et Matplotlib, améliorent encore sa capacité d’analyse efficace des données.

Ces fonctionnalités font de Pandas un outil indispensable dans la boîte à outils de la science des données. Ainsi, même si Python est un langage extrêmement courant, vous ne devriez pas considérer cela comme un inconvénient. Il est aussi polyvalent qu’omniprésent – et la maîtrise de Python vous permet de tout faire, depuis l’analyse statistique, le nettoyage des données et la visualisation jusqu’à des choses plus « de niche » comme l’utilisation de Python. outils de vapotage et même traitement du langage naturel applications.

Calcul haute performance avec NumPy

NumPy améliore considérablement la capacité de Python en matière de calcul haute performance, notamment grâce à sa prise en charge de grands, tableaux multidimensionnels et des matrices. Il y parvient en fournissant une gamme complète de fonctions mathématiques conçues pour des opérations efficaces sur ces structures de données.

L’un des principales fonctionnalités de NumPy est son implémentation en C, qui permet l’exécution rapide de calculs mathématiques complexes à l’aide d’opérations vectorisées. Cela se traduit par une amélioration notable des performances par rapport à l’utilisation des structures de données et des boucles natives de Python pour des tâches similaires. Par exemple, des tâches telles que la multiplication matricielle, courantes dans de nombreux calculs scientifiques, peuvent être exécutées rapidement en utilisant des fonctions comme np.dot().

Les data scientists peuvent utiliser la gestion efficace des tableaux et les puissantes capacités de calcul de NumPy pour accélérer considérablement leur code Python, le rendant ainsi viable pour les applications nécessitant des niveaux élevés de calcul numérique.

Améliorer les performances grâce au multitraitement

Améliorer les performances grâce à multitraitement en Python implique d’utiliser le ‘multitraitement’ module pour exécuter des tâches en parallèle sur plusieurs cœurs de processeur au lieu de séquentiellement sur un seul cœur.

Ceci est particulièrement avantageux pour les tâches liées au processeur qui nécessitent des ressources de calcul importantes, car cela permet la division et l’exécution simultanée des tâches, réduisant ainsi le temps d’exécution global. L’utilisation de base consiste à créer ‘Processus’ objets et en spécifiant la fonction cible à exécuter en parallèle.

De plus, le ‘Piscine’ La classe peut être utilisée pour gérer plusieurs processus de travail et répartir les tâches entre eux, ce qui élimine une grande partie de la gestion manuelle des processus. Mécanismes de communication inter-processus comme ‘File d’attente’ et ‘Tuyau’ faciliter l’échange de données entre processus, tandis que les primitives de synchronisation telles que ‘Verrouillage’ et ‘Sémaphore’ garantir que les processus n’interfèrent pas les uns avec les autres lors de l’accès aux ressources partagées.

Pour améliorer encore l’exécution du code, des techniques telles que Compilation JIT avec bibliothèques tels que Numba peuvent accélérer considérablement le code Python en compilant dynamiquement des parties du code au moment de l’exécution.

Tirer parti des bibliothèques de niche pour une analyse de données approfondie

L’utilisation de bibliothèques Python spécifiques pour l’analyse des données peut considérablement améliorer votre travail. Par exemple, Pandas est parfait pour organiser et manipuler des données, tandis que PyTorch offre des capacités avancées d’apprentissage en profondeur avec prise en charge du GPU.

D’un autre côté, Plotly et Seaborn peuvent vous aider à rendre vos données plus compréhensibles et plus attrayantes lors de la création de visualisations. Pour les tâches plus exigeantes en termes de calcul, des bibliothèques comme LightGBM et XGBoost proposer des implémentations efficaces d’algorithmes d’amélioration du gradient qui gèrent de grands ensembles de données à haute dimensionnalité.

Chacune de ces bibliothèques est spécialisée dans différents aspects de l’analyse des données et de l’apprentissage automatique, ce qui en fait des outils précieux pour tout data scientist.

La visualisation des données en Python a considérablement progressé, offrant un large éventail de techniques pour présenter les données de manière significative et attrayante.

La visualisation avancée des données améliore non seulement l’interprétation des données, mais également aide à découvrir des modèles sous-jacentsdes tendances et des corrélations qui pourraient ne pas être évidentes avec les méthodes traditionnelles.

Maîtriser individuellement ce que vous pouvez faire avec Python est indispensable, mais avoir un aperçu de comment une plateforme Python peut être utilisée dans toute la mesure possible dans un contexte d’entreprise est un point qui ne manquera pas de vous distinguer des autres data scientists.

Voici quelques techniques avancées à considérer :

- Visualisations interactives. Les bibliothèques aiment Bokeh et Plotly permettent de créer des tracés dynamiques avec lesquels les utilisateurs peuvent interagir, comme zoomer sur des zones spécifiques ou survoler des points de données pour voir plus d’informations. Cette interactivité peut rendre les données complexes plus accessibles et compréhensibles.

- Types de graphiques complexes. Au-delà des graphiques linéaires et à barres de base, Python prend en charge les types de graphiques avancés comme les cartes thermiques, les diagrammes en boîte, les diagrammes en violon et des diagrammes encore plus spécialisés comme les diagrammes de nuages de pluie. Chaque type de graphique répond à un objectif spécifique et peut aider à mettre en évidence différents aspects des données, des distributions et corrélations aux comparaisons entre groupes.

- Personnalisation avec matplotlib. Matplotlib offre de nombreuses options de personnalisation, permettant un contrôle précis de l’apparence des parcelles. Des techniques telles que l’ajustement des paramètres de tracé avec plt.getp et plt.setp Les fonctions ou la manipulation des propriétés des composants de tracé permettent de créer des figures de qualité publication qui transmettent vos données sous le meilleur jour possible.

- Visualisation de séries chronologiques. Pour les données temporelles, les tracés de séries chronologiques peuvent afficher efficacement les valeurs au fil du temps, aidant ainsi à identifier les tendances, les modèles ou les anomalies sur différentes périodes. Des bibliothèques comme Seaborn facilitent la création et la personnalisation de tracés de séries chronologiques, améliorant ainsi l’analyse des données temporelles.

Améliorer les performances grâce à multitraitement en Python permet l’exécution de code en parallèle, ce qui le rend idéal pour les tâches gourmandes en CPU sans nécessiter d’E/S ou d’interaction de l’utilisateur.

Différentes solutions sont adaptées à différents objectifs : de la création de simples graphiques linéaires aux tableaux de bord interactifs complexes et tout le reste. Voici quelques-uns des plus populaires :

- Infogramme se distingue par son interface conviviale et sa bibliothèque de modèles diversifiée, s’adressant à un large éventail de secteurs, notamment les médias, le marketing, l’éducation et le gouvernement. Il propose un compte de base gratuit et divers plans tarifaires pour des fonctionnalités plus avancées.

- Graphiques de fusion permet la création de plus de 100 types différents de graphiques et de cartes interactifs, conçus pour les projets Web et mobiles. Il prend en charge la personnalisation et offre diverses options d’exportation.

- Terrain offre une syntaxe simple et de multiples options d’interactivité, adaptées même à ceux qui n’ont aucune formation technique, grâce à son interface graphique. Cependant, sa version communautaire présente des limites telles que des visualisations publiques et un nombre limité d’esthétiques.

- Graphiques RAW est un framework open source mettant l’accent sur la visualisation des données sans code, par glisser-déposer, rendant les données complexes visuellement faciles à comprendre pour tout le monde. Il est particulièrement adapté pour combler le fossé entre les applications de feuilles de calcul et les éditeurs de graphiques vectoriels.

- QlikView est privilégié par les data scientists bien établis pour analyser des données à grande échelle. Il s’intègre à un large éventail de sources de données et est extrêmement rapide dans l’analyse des données.

La maîtrise des techniques avancées de Python est cruciale pour les data scientists afin de libérer tout le potentiel de ce langage puissant. Bien que les compétences de base en Python soient inestimables, la maîtrise de la manipulation sophistiquée des données, l’optimisation des performances et l’exploitation de bibliothèques spécialisées élèvent vos capacités d’analyse des données.

Un apprentissage continu, relever les défis et rester à jour sur les derniers développements de Python sont essentiels pour devenir un praticien compétent.

Alors, investissez du temps dans la maîtrise des fonctionnalités avancées de Python pour vous permettre d’aborder des tâches complexes d’analyse de données, de stimuler l’innovation et de prendre des décisions basées sur les données qui créent un réel impact.

Nahla Davies est développeur de logiciels et rédacteur technique. Avant de consacrer son travail à plein temps à la rédaction technique, elle a réussi, entre autres choses intrigantes, à devenir programmeuse principale dans une organisation de marque expérientielle Inc. 5 000 dont les clients incluent Samsung, Time Warner, Netflix et Sony.