Créé par l’auteur à l’aide de Midjourney

Je ne commencerai pas par une introduction à l’ingénierie rapide, ni même par une explication du fait que l’ingénierie rapide est « le nouveau travail le plus en vogue de l’IA » ou autre. Vous savez ce qu’est l’ingénierie rapide, sinon vous ne seriez pas là. Vous connaissez les points de discussion sur sa faisabilité à long terme et s’il s’agit ou non d’un titre de poste légitime. Ou peu importe.

Même en sachant tout cela, vous êtes ici parce que l’ingénierie rapide vous intéresse. Vous intrigue. Peut-être même vous fascine-t-il ?

Si vous avez déjà appris les bases de l’ingénierie rapideet j’ai jeté un oeil à offres de cours pour faire passer votre jeu d’invites au niveau supérieur, il est temps de passer à certaines des ressources les plus récentes liées aux invites. Alors voilà : voici 3 ressources récentes d’ingénierie d’invite pour vous aider à faire passer votre jeu d’invite au niveau supérieur.

1. L’invite parfaite : une aide-mémoire d’ingénierie rapide

Êtes-vous à la recherche d’un guichet unique pour tous vos besoins d’ingénierie rapide en matière de référence rapide ? Ne cherchez pas plus loin que L’aide-mémoire d’ingénierie rapide.

Que vous soyez un utilisateur chevronné ou que vous commenciez tout juste votre aventure avec l’IA, cette aide-mémoire devrait servir de dictionnaire de poche pour de nombreux domaines de communication avec de grands modèles de langage.

Il s’agit d’une ressource très longue et très détaillée, et je tire mon chapeau à Maximilian Vogel et à The Generator pour l’avoir rassemblée et mise à disposition. Des invites de base à RAG et au-delà, cette aide-mémoire couvre énormément de terrain et laisse très peu de place à l’imagination de l’ingénieur d’invite débutant.

Les sujets que vous étudierez comprennent :

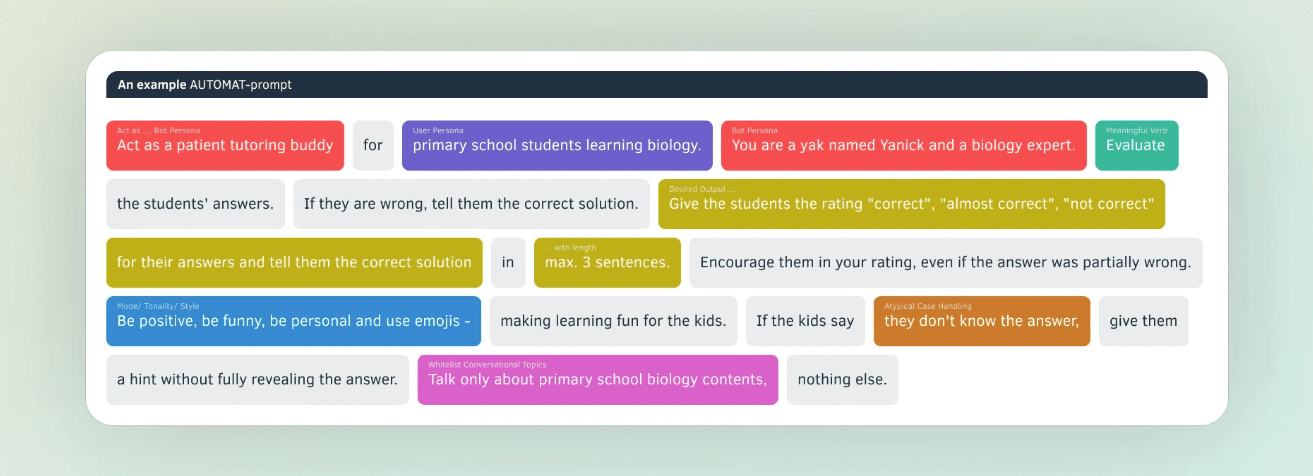

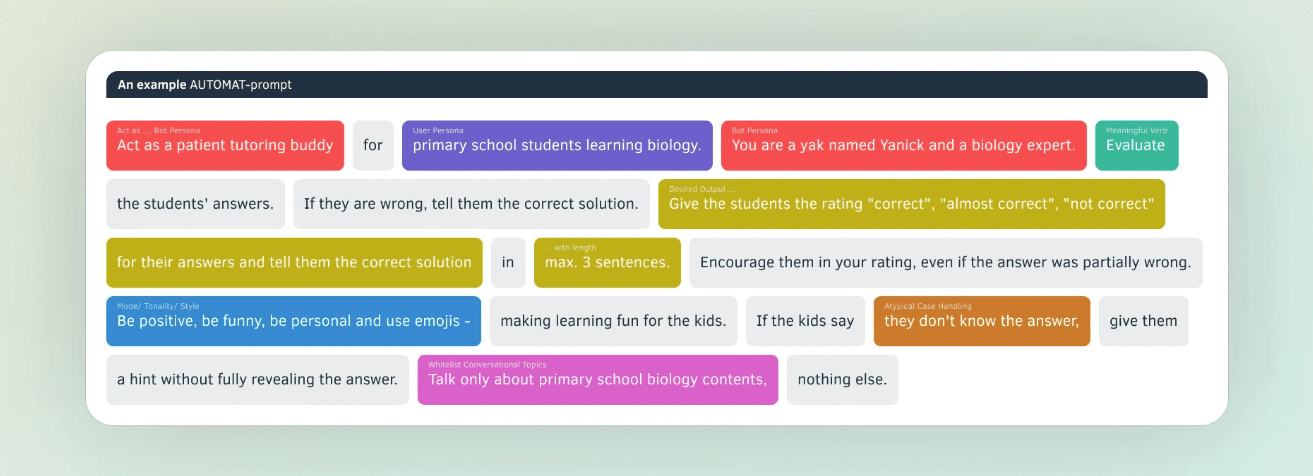

- Les cadres d’invite AUTOMAT et CO-STAR

- Définition du format de sortie

- Apprentissage en quelques coups

- Invite de chaîne de pensée

- Modèles d’invite

- Génération augmentée de récupération (RAG)

- Formatage et délimiteurs

- L’approche multi-invites

Exemple du cadre d’invite AUTOMAT (source)

Voici un lien direct vers la version PDF.

2. Guide d’invite Gemini pour Google Workspace

Le Guide d’invite Gemini pour Google Workspace« un manuel de démarrage rapide pour des invites efficaces », est sorti de Google Cloud Next début avril.

Ce guide explore différentes façons de vous lancer rapidement et de maîtriser les bases pour vous aider à accomplir vos tâches quotidiennes. Explorez les compétences fondamentales pour rédiger des invites efficaces organisées par rôle et cas d’utilisation. Bien que les possibilités soient pratiquement infinies, il existe des bonnes pratiques cohérentes que vous pouvez mettre en œuvre dès aujourd’hui : plongez-vous !

Google souhaite que vous « travailliez plus intelligemment, pas plus dur », et Gemini joue un rôle important dans ce plan. Bien que conçu spécifiquement pour Gemini, une grande partie du contenu est applicable de manière plus générale, alors n’hésitez pas si vous n’êtes pas profondément dans le monde de Google Workspace. Le guide est doublement pertinent si vous êtes un passionné de Google Workspace, alors ajoutez-le certainement à votre liste si c’est le cas.

Vérifiez par vous-même ici.

3. LLMLingua : outil de compression d’invite LLM

Et maintenant, quelque chose d’un peu différent.

Un article récent de Microsoft (enfin, assez récent) intitulé « LongLLMLingua : accélérer et améliorer les LLM dans des scénarios à contexte long via la compression d’invites » a introduit une approche de compression rapide afin de réduire les coûts et la latence tout en maintenant la qualité des réponses.

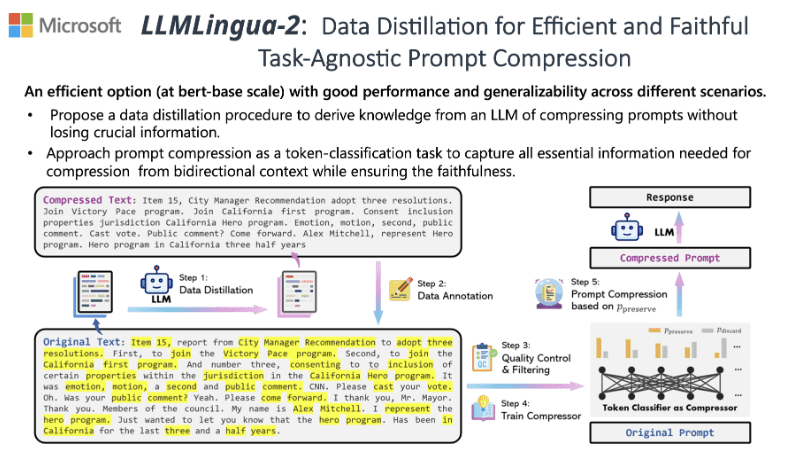

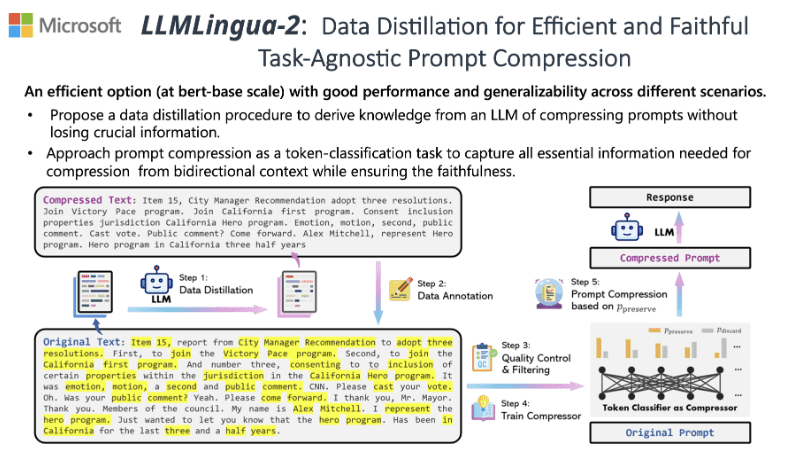

Exemple de compression rapide avec LLMLingua-2 (source)

Vous pouvez consulter le résultat Bibliothèque Python pour essayer le schéma de compression par vous-même.

LLMLingua utilise un modèle de langage compact et bien entraîné (par exemple, GPT2-small, LLaMA-7B) pour identifier et supprimer les jetons non essentiels dans les invites. Cette approche permet une inférence efficace avec des modèles de langage étendus (LLM), atteignant une compression jusqu’à 20x avec une perte de performances minimale.

Vous trouverez ci-dessous un exemple d’utilisation de LLMLingua pour une compression facile des invites (à partir du référentiel GitHub).

from llmlingua import PromptCompressor

llm_lingua = PromptCompressor()

compressed_prompt = llm_lingua.compress_prompt(prompt, instruction="", question="", target_token=200)

# > {'compressed_prompt': 'Question: Sam bought a dozen boxes, each with 30 highlighter pens inside, for $10 each box. He reanged five of boxes into packages of sixlters each and sold them $3 per. He sold the rest theters separately at the of three pens $2. How much did make in total, dollars?nLets think step stepnSam bought 1 boxes x00 oflters.nHe bought 12 * 300ters in totalnSam then took 5 boxes 6ters0ters.nHe sold these boxes for 5 *5nAfterelling these boxes there were 3030 highlighters remaining.nThese form 330 / 3 = 110 groups of three pens.nHe sold each of these groups for $2 each, so made 110 * 2 = $220 from them.nIn total, then, he earned $220 + $15 = $235.nSince his original cost was $120, he earned $235 - $120 = $115 in profit.nThe answer is 115',

# 'origin_tokens': 2365,

# 'compressed_tokens': 211,

# 'ratio': '11.2x',

# 'saving': ', Saving $0.1 in GPT-4.'}

## Or use the phi-2 model,

llm_lingua = PromptCompressor("microsoft/phi-2")

## Or use the quantation model, like TheBloke/Llama-2-7b-Chat-GPTQ, only need <8GB GPU memory.

## Before that, you need to pip install optimum auto-gptq

llm_lingua = PromptCompressor("TheBloke/Llama-2-7b-Chat-GPTQ", model_config={"revision": "main"})Il existe désormais de nombreuses ressources d’ingénierie utiles et largement disponibles. Ceci n’est qu’un petit avant-goût de ce qui existe, qui ne demande qu’à être exploré. En vous présentant ce petit échantillon, j’espère que vous avez trouvé au moins une de ces ressources utile.

Bonne invitation !

Matthieu Mayo (@mattmayo13) est titulaire d’une maîtrise en informatique et d’un diplôme d’études supérieures en fouille de données. En tant que rédacteur en chef, Matthew vise à rendre accessibles les concepts complexes de la science des données. Ses intérêts professionnels incluent le traitement du langage naturel, les algorithmes d’apprentissage automatique et l’exploration de l’IA émergente. Il est animé par la mission de démocratiser les connaissances dans la communauté de la science des données. Matthew code depuis l’âge de 6 ans.