Image par auteur

Tout le monde se concentre sur la création de meilleurs LLM (grands modèles de langage), tandis que Groq se concentre sur le côté infrastructure de l’IA, rendant ces grands modèles plus rapides.

Dans ce didacticiel, nous découvrirons le moteur d’inférence Groq LPU et comment l’utiliser localement sur votre ordinateur portable à l’aide de l’API et de Jan AI. Nous l’intégrerons également dans VSCode pour nous aider à générer du code, à le refactoriser, à le documenter et à générer des unités de test. Nous créerons gratuitement notre propre assistant de codage IA.

Qu’est-ce que le moteur d’inférence Groq LPU ?

Le Grok Le moteur d’inférence LPU (Language Processing Unit) est conçu pour générer des réponses rapides pour les applications à forte intensité de calcul avec un composant séquentiel, telles que les LLM.

Par rapport au CPU et au GPU, le LPU a une plus grande capacité de calcul, ce qui réduit le temps nécessaire pour prédire un mot, ce qui rend la génération de séquences de texte beaucoup plus rapide. De plus, LPU gère également les goulots d’étranglement de la mémoire pour offrir de meilleures performances sur les LLM par rapport aux GPU.

En bref, la technologie Groq LPU rend vos LLM ultra rapides, permettant des applications d’IA en temps réel. Lis le Papier Groq ISCA 2022 pour en savoir plus sur l’architecture LPU.

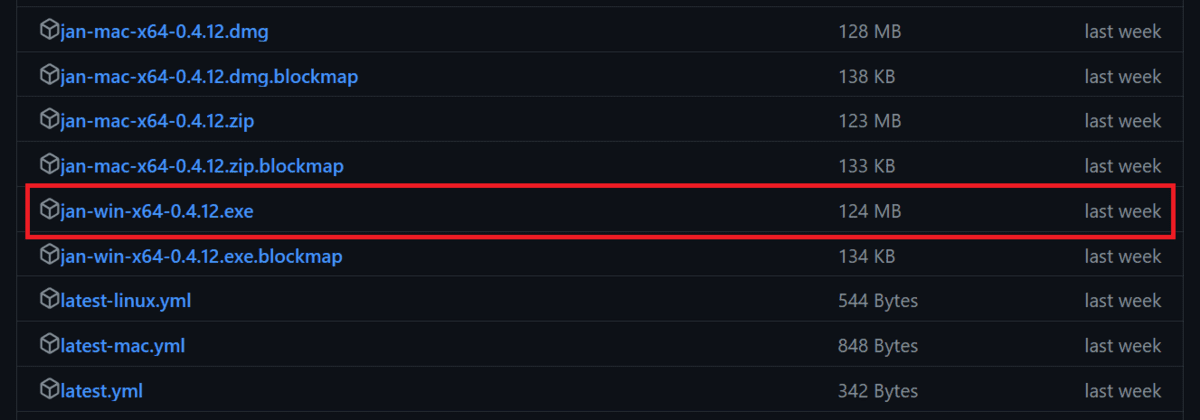

Installation de Jan AI

Jan AI est une application de bureau qui exécute localement de grands modèles de langage open source et propriétaires. Il est disponible en téléchargement pour Linux, macOS et Windows. Nous allons télécharger et installer Jan AI sous Windows en accédant au Sorties · janhq/jan (github.com) et en cliquant sur le fichier avec l’extension « .exe ».

Si vous souhaitez utiliser les LLM localement pour améliorer la confidentialité, lisez les 5 façons d’utiliser les LLM sur votre ordinateur portable bloguez et commencez à utiliser des modèles de langage open source haut de gamme.

Création de l’API Groq Cloud

Pour utiliser Grog Llama 3 dans Jan AI, nous avons besoin d’une API. Pour ce faire, nous allons créer un compte Groq Cloud en allant sur https://console.groq.com/.

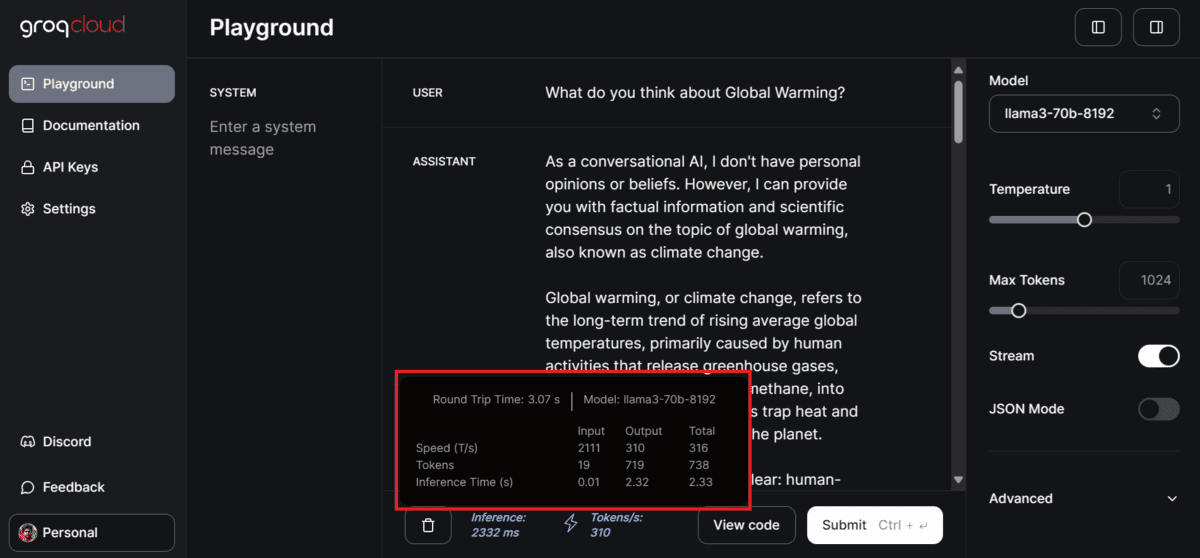

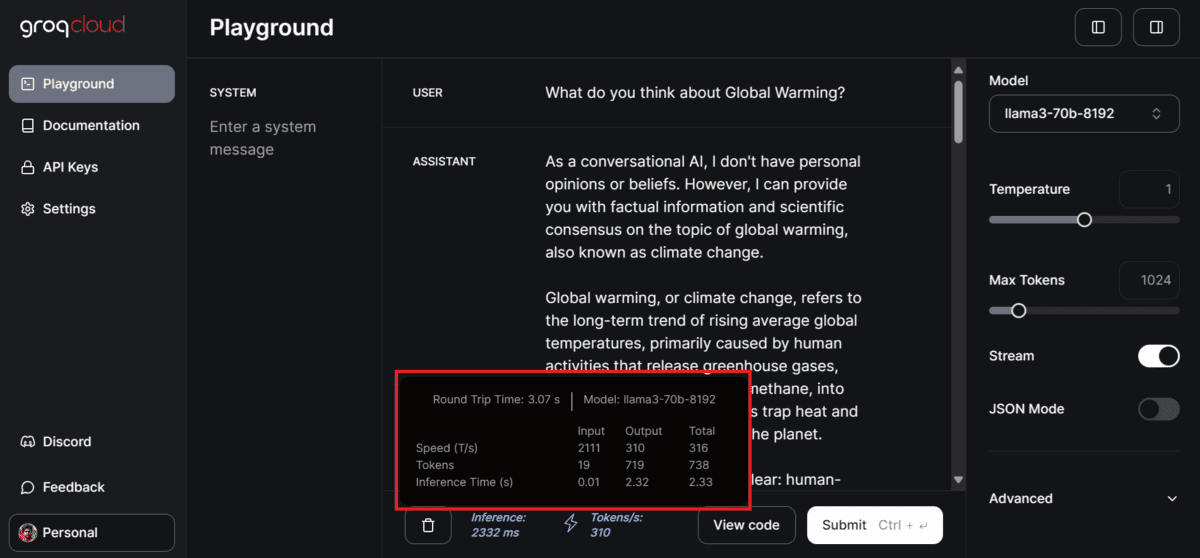

Si vous souhaitez tester les différents modèles proposés par Groq, vous pouvez le faire sans rien configurer en allant dans l’onglet « Playground », en sélectionnant le modèle et en ajoutant la saisie de l’utilisateur.

Dans notre cas, c’était super rapide. Il a généré 310 jetons par seconde, ce qui est de loin le maximum que j’ai vu dans ma vie. Même Azure AI ou OpenAI ne peuvent pas produire ce type de résultat.

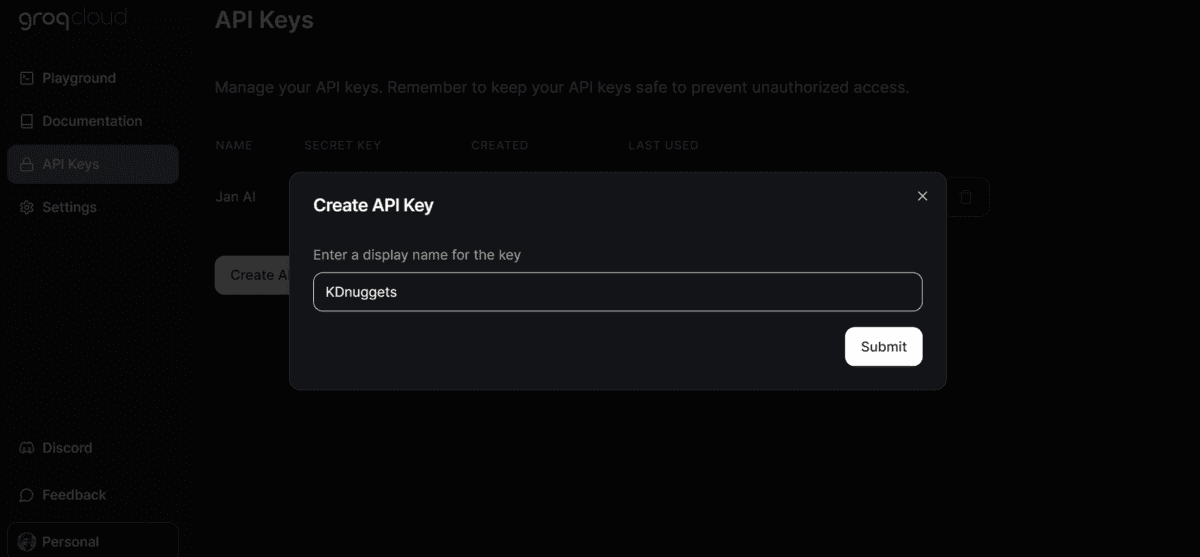

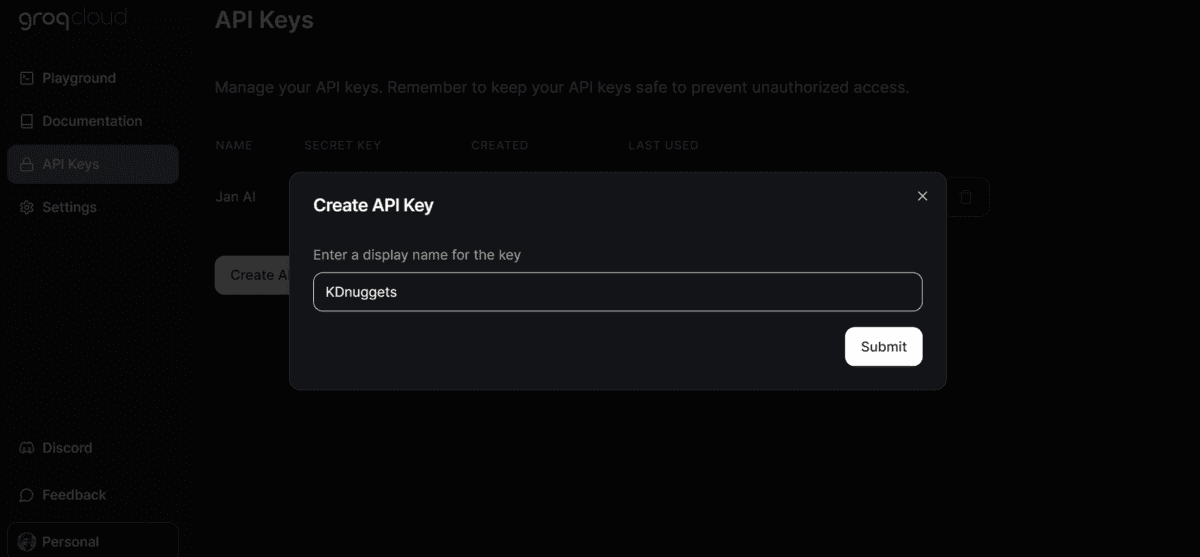

Pour générer la clé API, cliquez sur le bouton « Clés API » dans le panneau de gauche, puis cliquez sur le bouton « Créer une clé API » pour créer puis copier la clé API.

Utiliser Groq en janvier AI

Dans la prochaine étape, nous collerons la clé API Groq Cloud dans l’application Jan AI.

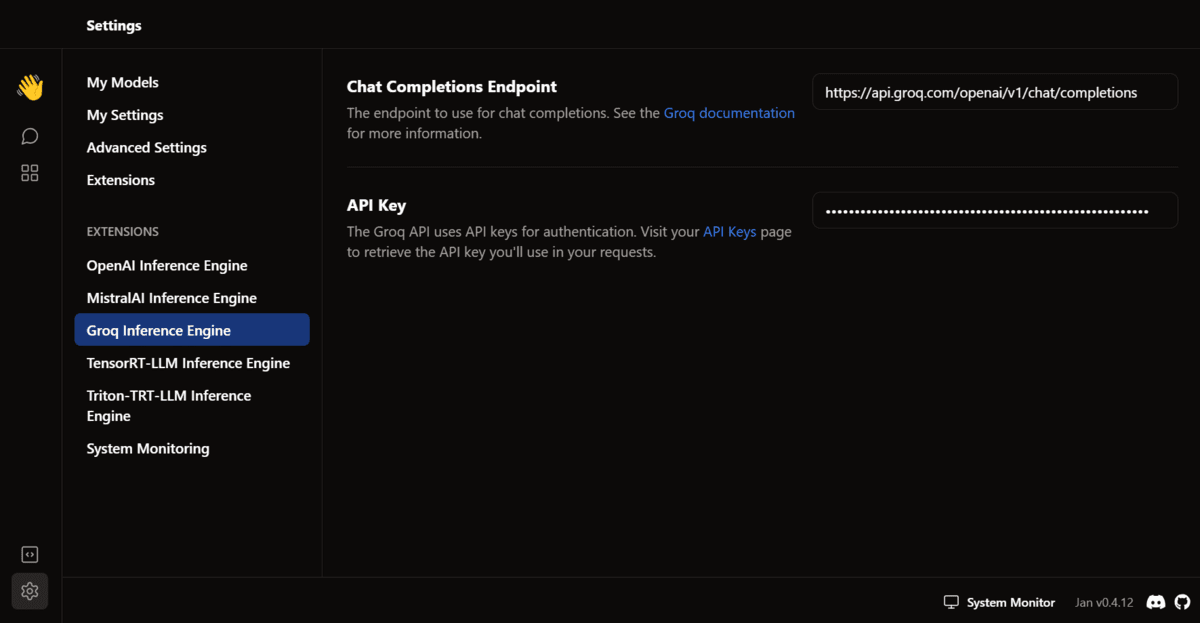

Lancez l’application Jan AI, accédez aux paramètres, sélectionnez l’option « Groq Inference Engine » dans la section extension et ajoutez la clé API.

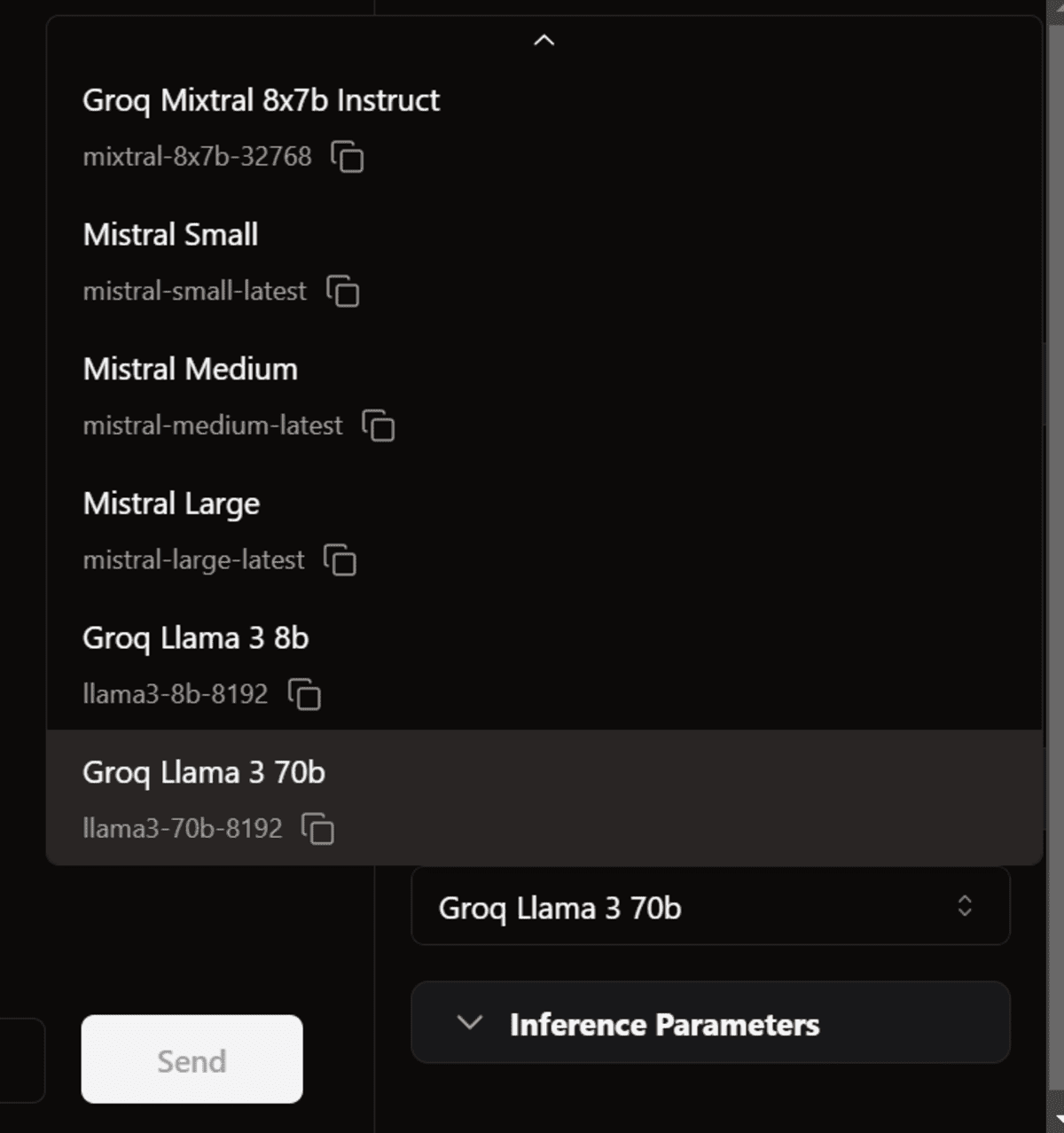

Ensuite, revenez à la fenêtre du fil de discussion. Dans la section modèle, sélectionnez le Groq Llama 3 70B dans la section « Télécommande » et lancez l’invite.

La génération de réponses est si rapide que je ne peux même pas la suivre.

Note: La version gratuite de l’API présente certaines limitations. Visite https://console.groq.com/settings/limits pour en savoir plus sur eux.

Utiliser Groq dans VSCode

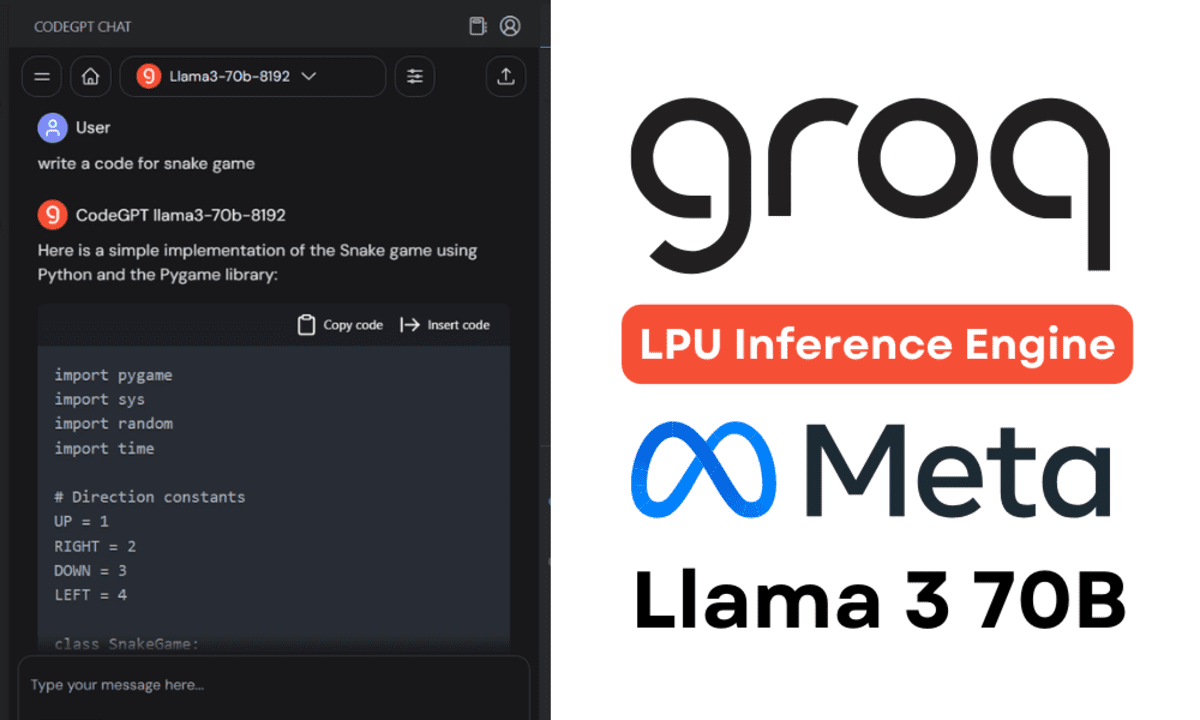

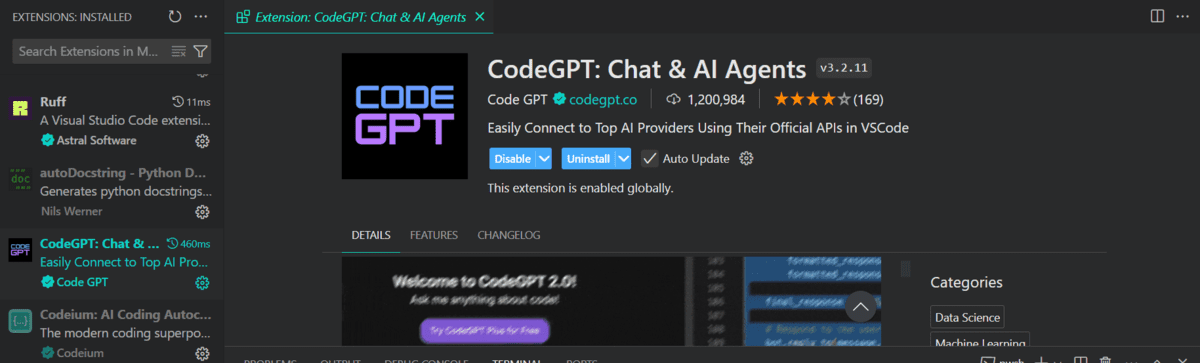

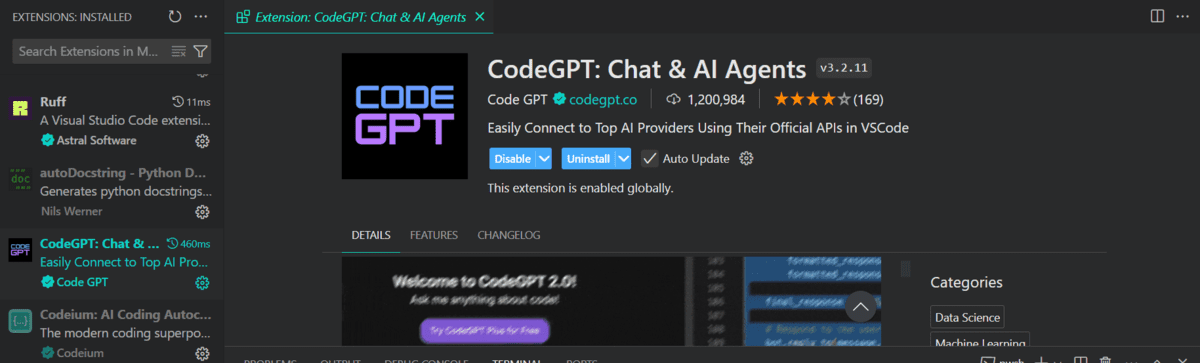

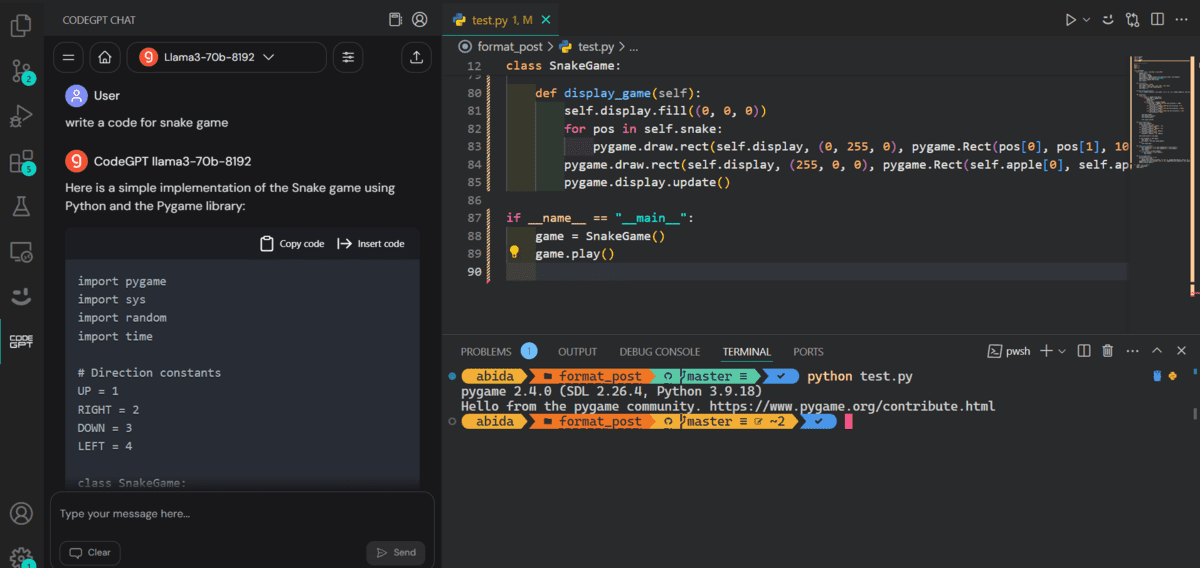

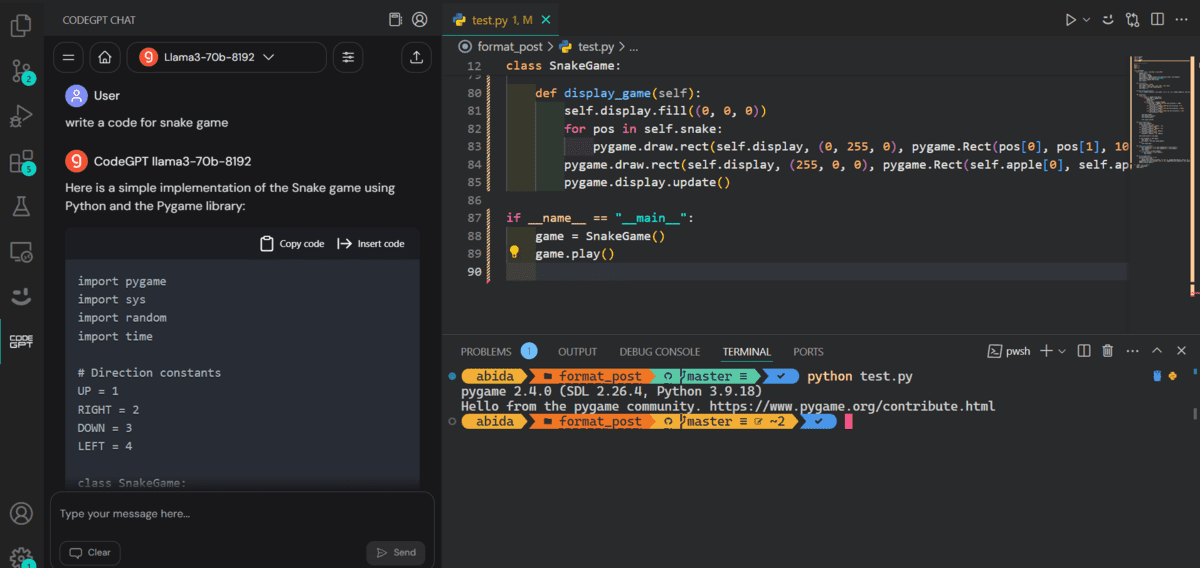

Ensuite, nous essaierons de coller la même clé API dans l’extension CodeGPT VSCode et de créer notre propre assistant de codage IA gratuit.

Installez l’extension CodeGPT en la recherchant dans l’onglet extension.

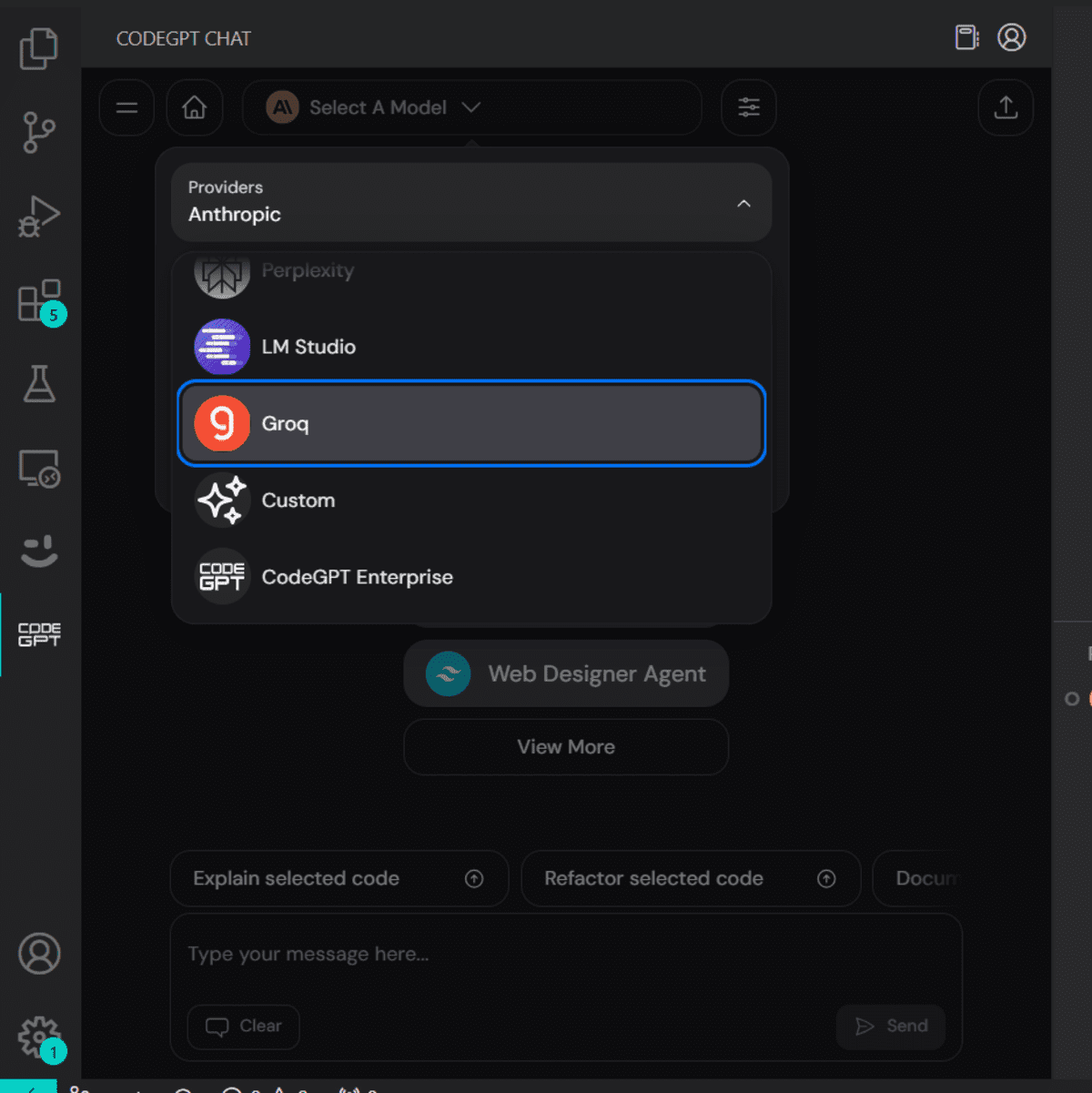

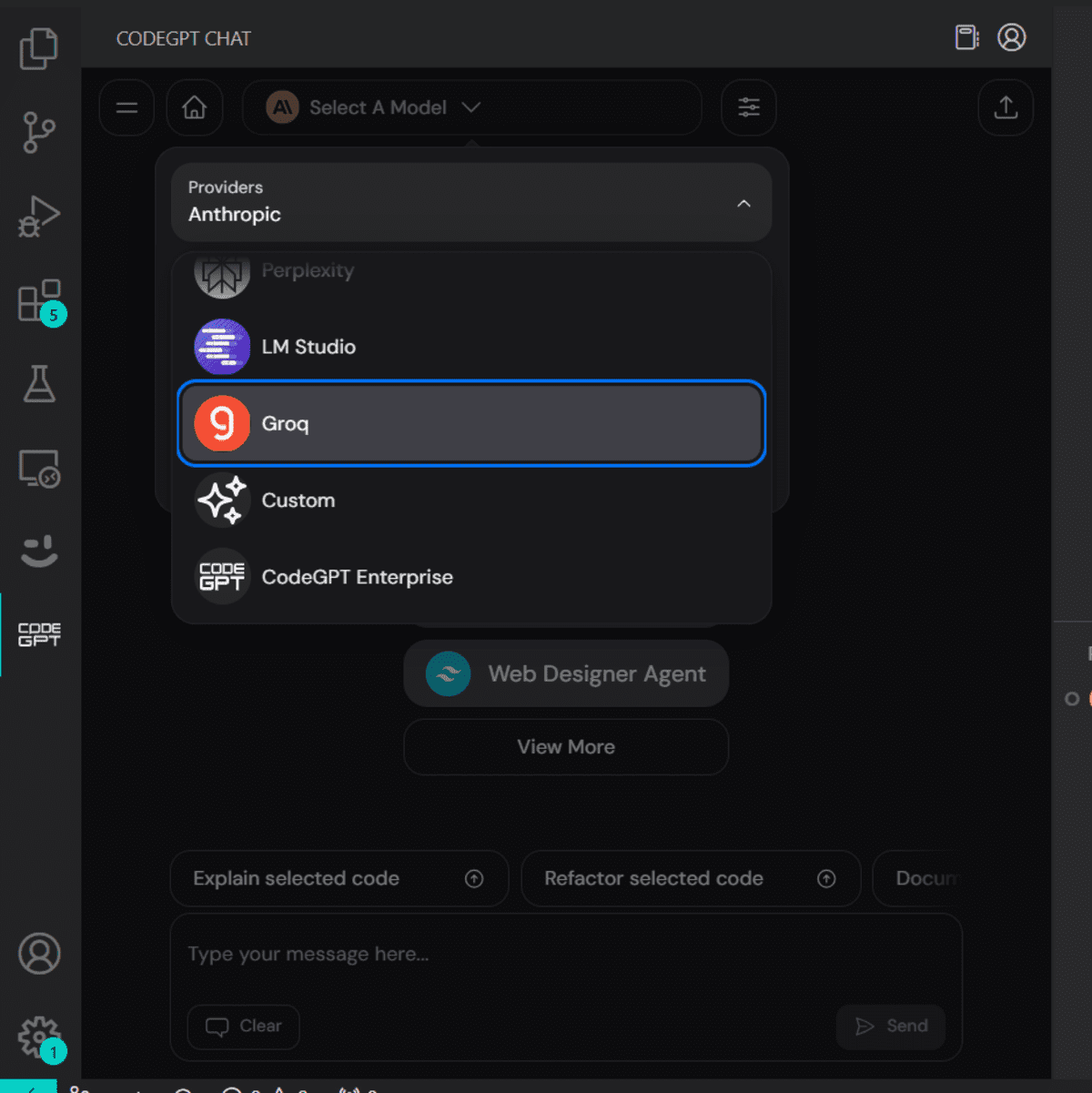

L’onglet CodeGPT apparaîtra pour vous permettre de sélectionner le fournisseur de modèles.

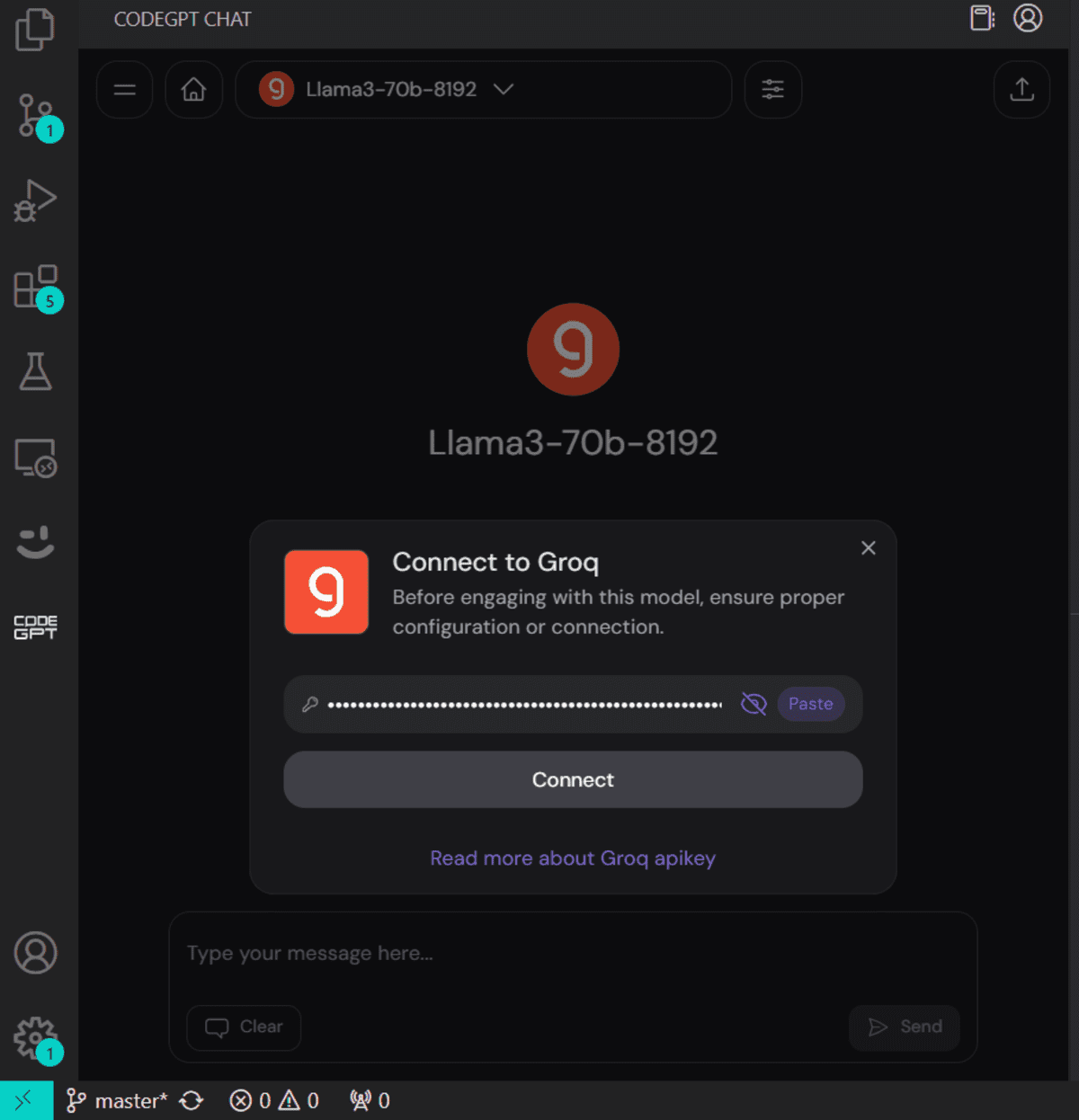

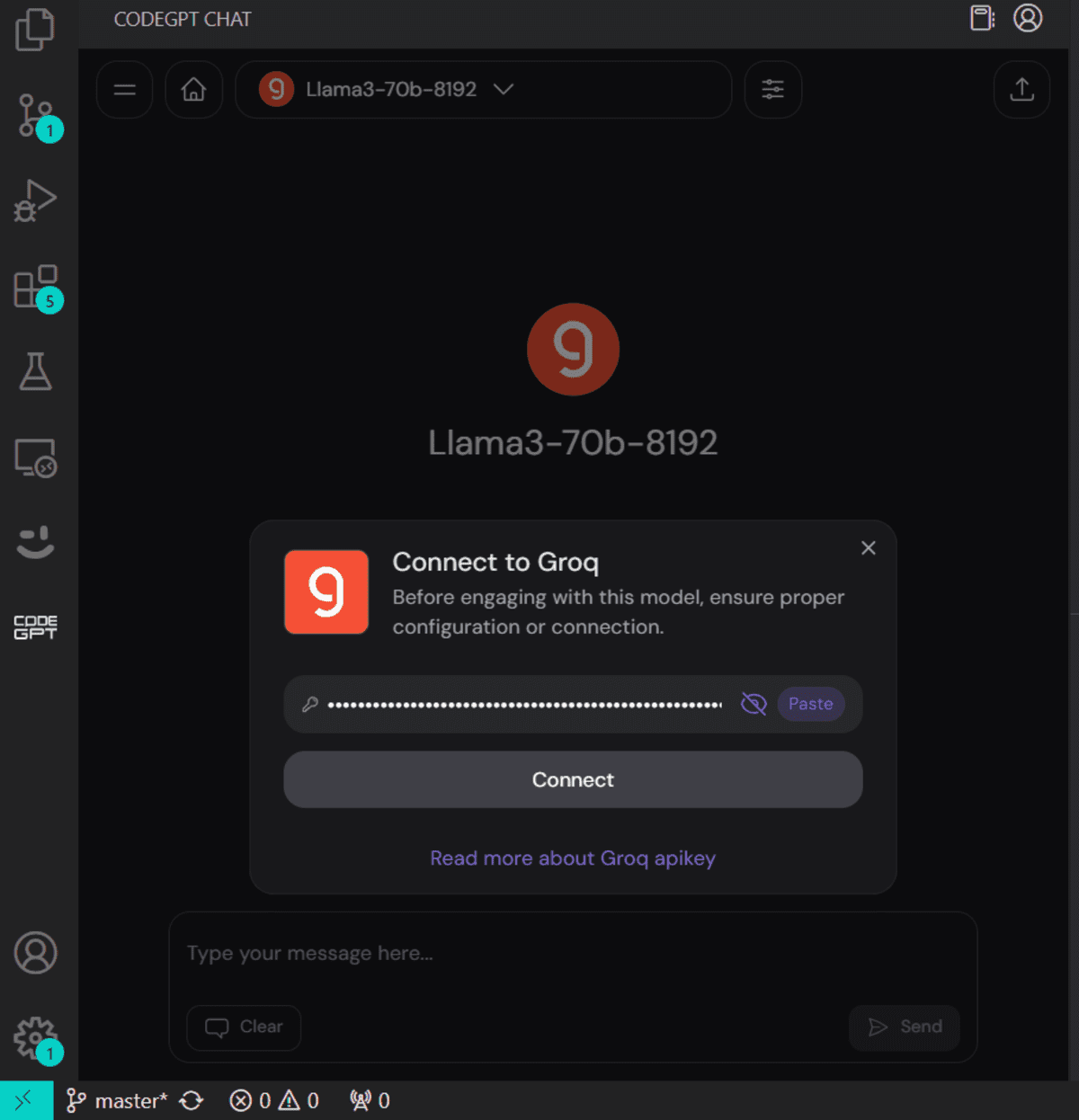

Lorsque vous sélectionnez Groq comme fournisseur de modèles, il vous demandera de fournir une clé API. Collez simplement la même clé API et nous sommes prêts à partir. Vous pouvez même générer une autre clé API pour CodeGPT.

Nous allons maintenant lui demander d’écrire du code pour le jeu du serpent. Il a fallu 10 secondes pour générer puis exécuter le code.

Voici la démo du fonctionnement de notre jeu de serpent.

En savoir plus sur les cinq meilleurs assistants de codage IA et devenez un développeur et un data scientist alimenté par l’IA. N’oubliez pas que l’IA est là pour nous aider, pas pour nous remplacer, alors soyez ouvert à elle et utilisez-la pour améliorer l’écriture de votre code.

Conclusion

Dans ce didacticiel, nous avons découvert Groq Inference Engine et comment y accéder localement à l’aide de l’application Windows Jan AI. Pour couronner le tout, nous l’avons intégré à notre flux de travail en utilisant les extensions CodeGPT VSCode, ce qui est génial. Il génère des réponses en temps réel pour une meilleure expérience de développement.

Désormais, la plupart des entreprises développeront leurs propres ingénieurs d’inférence pour correspondre à la vitesse de Groq. Sinon, Groq remportera la couronne dans quelques mois.

Abid Ali Awan (@1abidaliawan) est un professionnel certifié en data scientist qui adore créer des modèles d’apprentissage automatique. Actuellement, il se concentre sur la création de contenu et rédige des blogs techniques sur les technologies d’apprentissage automatique et de science des données. Abid est titulaire d’une maîtrise en gestion technologique et d’un baccalauréat en ingénierie des télécommunications. Sa vision est de créer un produit d’IA utilisant un réseau neuronal graphique pour les étudiants aux prises avec une maladie mentale.