La nécessité de la spécialisation

Imaginez un hôpital rempli de médecins spécialisés, chacun expert dans son domaine, collaborant pour offrir les meilleurs soins aux patients. Chirurgiens, cardiologues, pédiatres : tous unissent leurs compétences pour résoudre des problèmes uniques. De la même manière, l’IA peut bénéficier de la spécialisation.

L’architecture Mixture of Experts (MoE) en intelligence artificielle repose sur la collaboration de différents modèles spécialisés pour traiter des données complexes. Chaque expert dans un modèle MoE se concentre sur un aspect spécifique d’un problème plus vaste, améliorant ainsi l’efficacité, la précision et les performances globales du système.

Mistral AI propose des modèles de langage fondamental open source qui rivalisent avec ceux d’OpenAI. Leur modèle Mixtral 8x7B, utilisant une architecture MoE, représente une avancée majeure dans les grands modèles de langage (LLM). Nous explorerons pourquoi Mixtral se distingue et pourquoi les LLM modernes adoptent l’architecture MoE, en mettant en avant sa vitesse, sa taille et sa précision.

Méthodes courantes d’amélioration des LLM

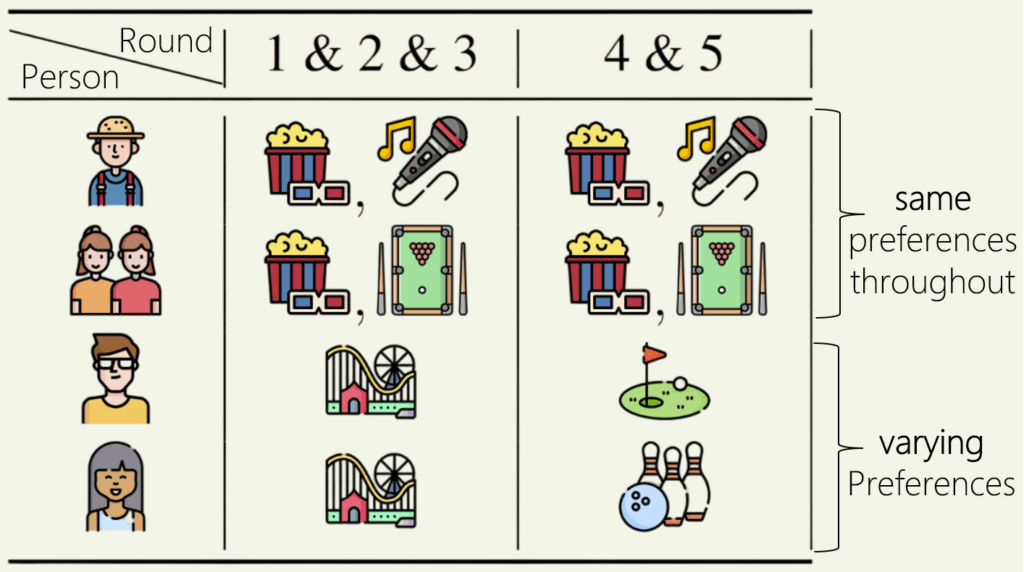

Pour comprendre comment l’architecture MoE améliore les LLM, examinons les méthodes courantes d’amélioration de leur efficacité. Les praticiens et développeurs d’IA améliorent les modèles en augmentant les paramètres, en ajustant l’architecture ou en affinant les réglages.

- Augmentation des paramètres : En fournissant plus d’informations, la capacité du modèle à apprendre et à représenter des modèles complexes augmente. Cependant, cela peut entraîner un surapprentissage et des hallucinations, nécessitant un apprentissage par renforcement à partir de la rétroaction humaine (RLHF).

- Modification de l’architecture : L’ajout de nouvelles couches ou modules améliore les performances sur des tâches spécifiques, bien que cela soit difficile à mettre en œuvre.

- Réglage fin : Les modèles pré-entraînés peuvent être affinés sur des données spécifiques ou via un apprentissage par transfert, permettant aux LLM existants de gérer de nouvelles tâches sans repartir de zéro. C’est la méthode la plus simple et ne nécessite pas de modifications significatives du modèle.

Qu’est-ce que l’architecture MoE ?

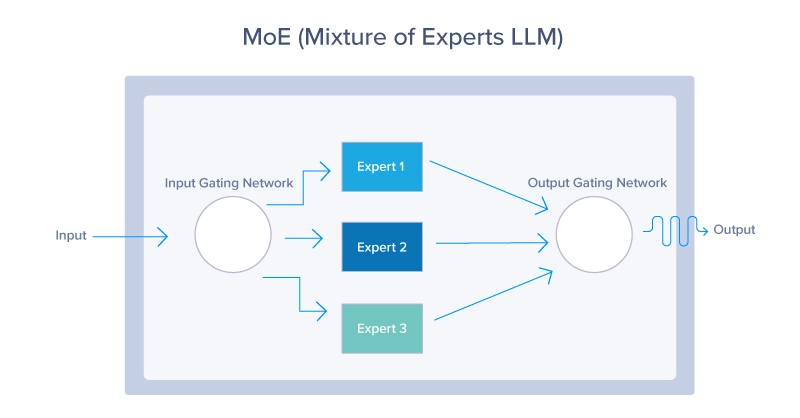

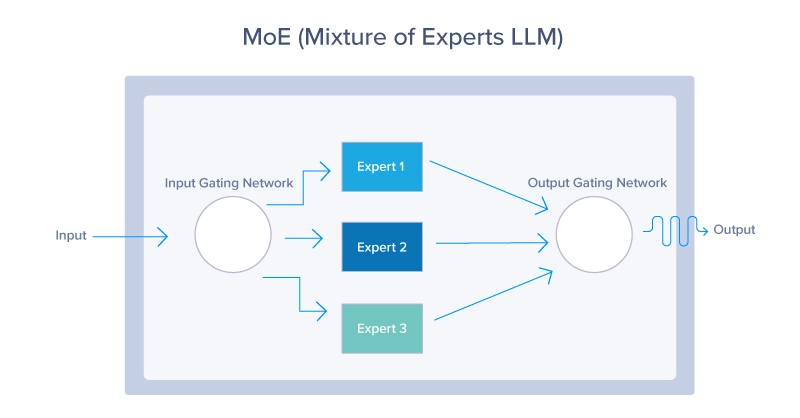

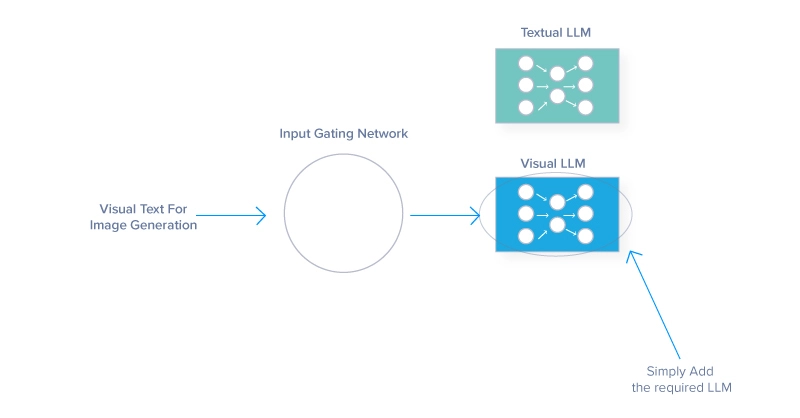

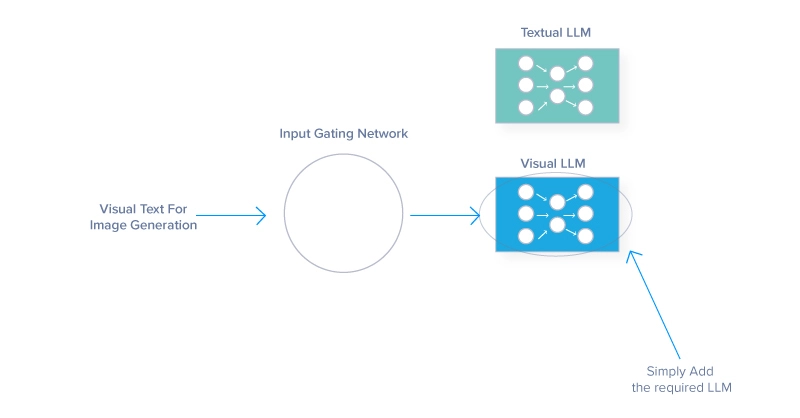

L’architecture Mixture of Experts (MoE) est une conception de réseau neuronal qui améliore l’efficacité et les performances en activant dynamiquement un sous-ensemble de réseaux spécialisés, appelés experts, pour chaque entrée. Un réseau de contrôle détermine quels experts activer, réduisant ainsi les coûts de calcul. L’architecture MoE se compose de deux composants essentiels : le réseau de contrôle et les experts.

En essence, l’architecture MoE fonctionne comme un système de trafic efficace, dirigeant chaque donnée vers l’expert le plus approprié. Ce routage dynamique garantit que les ressources les plus compétentes sont utilisées pour chaque tâche, améliorant ainsi l’efficacité globale du modèle. L’architecture MoE tire parti des trois manières d’améliorer la fidélité d’un modèle.

- En mettant en œuvre plusieurs experts, le MoE augmente intrinsèquement la portée du modèle.

- En ajoutant plus de paramètres par expert.

- En modifiant l’architecture classique du réseau neuronal pour intégrer un réseau de contrôle déterminant les experts à employer pour une tâche donnée.

- Chaque expert d’un MoE est finement réglé pour fonctionner comme prévu, ajoutant une couche supplémentaire de réglage dont les modèles traditionnels ne peuvent pas bénéficier.

Réseau de contrôle du MoE

Le réseau de contrôle agit comme un décideur au sein du modèle MoE. Il évalue les tâches entrantes et détermine quel expert est apte à les gérer, en se basant sur des poids appris ajustés au fil du temps grâce à la formation. Le réseau de contrôle peut utiliser diverses stratégies, des méthodes probabilistes aux méthodes déterministes.

Experts du MoE

Chaque expert du modèle MoE représente un réseau neuronal plus petit, un modèle d’apprentissage automatique ou un LLM optimisé pour un sous-ensemble spécifique du domaine problématique. Par exemple, chez Mistral, différents experts peuvent se spécialiser dans la compréhension de certaines langues ou types de requêtes. Cette spécialisation garantit que chaque expert maîtrise son créneau, conduisant à des performances supérieures dans un large éventail de tâches.

Fonction de perte MoE

Bien qu’elle ne soit pas un composant principal de l’architecture MoE, la fonction de perte joue un rôle central dans les performances futures du modèle. Elle combine généralement les pertes calculées pour chaque expert, pondérées par la probabilité ou l’importance attribuée par le réseau de contrôle, permettant d’affiner les experts pour leurs tâches spécifiques tout en ajustant le réseau de contrôle pour améliorer la précision du routage.

Le processus MoE du début à la fin

Voici une explication résumée du fonctionnement du processus de routage du début à la fin :

- Traitement des entrées : traitement initial des données entrantes, principalement notre invite dans le cas des LLM.

- Extraction de fonctionnalités : transformation des entrées brutes pour l’analyse.

- Évaluation du réseau de contrôle : évaluation de l’adéquation des experts via des probabilités ou des poids.

- Routage pondéré : allocation des entrées en fonction des poids calculés. Dans certains cas, plusieurs LLM sont choisis pour répondre à une seule entrée.

- Exécution des tâches : traitement des entrées allouées par chaque expert.

- Intégration des résultats des experts : combiner les résultats des experts individuels pour le résultat final.

- Rétroaction et adaptation : utiliser les commentaires sur les performances pour améliorer les modèles.

- Optimisation itérative : affinement continu des paramètres de routage et de modèle.

Modèles populaires utilisant une architecture MoE

- GPT-4 et GPT-4o d’OpenAI : Ces modèles multimodaux utilisent MoE pour ingérer différents supports tels que des images, du texte et de la voix. GPT-4 compte 8 experts avec chacun 220 milliards de paramètres, totalisant plus de 1,7 billion de paramètres.

- Mistral 8x7b de Mistral AI : Ce modèle open source utilise une architecture sMoE (sparse Mixture of Experts) avec 46,7 milliards de paramètres, mais n’utilise que 12,9 milliards de paramètres par jeton. Il surpasse Llama2 (70B) et GPT-3.5 (175B) tout en étant moins coûteux à exploiter.

Les avantages du MoE et pourquoi c’est l’architecture préférée

L’architecture MoE représente un changement de paradigme dans la manière d’aborder les tâches complexes d’apprentissage automatique, offrant des avantages uniques et démontrant sa supériorité sur les modèles traditionnels.

- Évolutivité améliorée du modèle :

- Chaque expert est responsable d’une partie d’une tâche, donc la mise à l’échelle en ajoutant des experts n’augmente pas proportionnellement les demandes de calcul.

- Cette approche modulaire facilite le traitement parallèle, accélérant ainsi les opérations.

- La polyvalence permet au modèle d’étendre ses capacités à différents types d’entrées de données.

- Efficacité et flexibilité améliorées :

- Les modèles MoE sont extrêmement efficaces, engageant uniquement les experts nécessaires pour des entrées spécifiques.

- L’architecture réduit la charge de calcul par inférence, permettant au modèle de s’adapter à différents types de données et tâches spécialisées.

- Spécialisation et précision :

- Chaque expert peut être adapté avec précision à des aspects spécifiques du problème global, conduisant à une plus grande expertise et précision.

- Cette spécialisation est utile dans des domaines comme l’imagerie médicale ou les prévisions financières, où la précision est essentielle.

- Le MoE peut générer de meilleurs résultats dans des domaines restreints grâce à sa compréhension nuancée et sa capacité à surpasser les modèles généralistes sur des tâches spécialisées.

Les inconvénients de l’architecture MoE

Bien que l’architecture MoE offre des avantages significatifs, elle présente également des défis qui peuvent impacter son adoption et son efficacité.

- Complexité du modèle : La gestion de plusieurs experts et d’un réseau de contrôle rend le développement et les coûts opérationnels du MoE difficiles.

- Stabilité de la formation : L’interaction entre le réseau de contrôle et les experts introduit une dynamique imprévisible, nécessitant un réglage approfondi des hyperparamètres.

- Déséquilibre : Laisser des experts inactifs constitue une mauvaise optimisation, impliquant des ressources gaspillées. Équilibrer la répartition de la charge de travail est crucial pour une IA MoE performante.

Il est important de noter que ces inconvénients tendent à diminuer avec le temps à mesure que l’architecture MoE s’améliore.

L’avenir façonné par la spécialisation

Tout comme les équipes spécialisées réalisent plus qu’une main-d’œuvre généralisée, les modèles spécialisés surpassent leurs homologues monolithiques dans les modèles d’IA. La spécialisation transforme la complexité des problèmes à grande échelle en segments gérables que les experts peuvent aborder efficacement.

En regardant vers l’avenir, les principes du MoE pourraient influencer les développements dans des secteurs tels que la santé, la finance et les systèmes autonomes, en promouvant des solutions plus efficaces et précises.

L’aventure du MoE ne fait que commencer et son évolution continue promet de stimuler davantage l’innovation dans le domaine de l’IA et au-delà. À mesure que le matériel haute performance progresse, ce mélange d’IA expertes pourrait résider dans nos smartphones, offrant des expériences encore plus intelligentes. Mais d’abord, il faudra que quelqu’un en forme un.

Kevin Vu gère le Blog d’Exxact Corp. et collabore avec plusieurs auteurs talentueux qui écrivent sur divers aspects du Deep Learning.