Vous est-il déjà arrivé de ne connaître qu’une partie de la réponse à une question ? Pour obtenir une réponse plus complète, il est souvent utile de consulter un ami plus informé sur le sujet.

Ce principe de collaboration peut également améliorer la précision des grands modèles linguistiques (LLM). Cependant, enseigner aux LLM quand collaborer avec un autre modèle a été un défi. Plutôt que d’utiliser des formules complexes ou de grandes quantités de données étiquetées, les chercheurs du laboratoire d’informatique et d’intelligence artificielle (CSAIL) du MIT ont adopté une approche plus naturelle.

Leur nouvel algorithme, appelé « Co-LLM », associe un LLM généraliste à un modèle spécialisé pour qu’ils travaillent ensemble. Au fur et à mesure que le premier modèle élabore une réponse, Co-LLM examine chaque mot pour déterminer où une réponse plus précise du modèle expert est nécessaire. Ce processus améliore la précision des réponses à des questions médicales, mathématiques et de raisonnement, tout en étant plus efficace puisque le modèle expert n’est sollicité que lorsque nécessaire.

Pour décider quand un modèle généraliste a besoin de l’aide d’un modèle expert, le cadre utilise l’apprentissage automatique pour former une « variable de commutation », un outil qui évalue la compétence de chaque mot dans les réponses des deux LLM. Cette variable agit comme un chef de projet, identifiant les domaines nécessitant l’intervention d’un spécialiste. Par exemple, si vous demandez au Co-LLM de citer des espèces d’ours disparues, le LLM généraliste commence à répondre, et la variable de commutation insère des informations plus précises du modèle expert, comme l’année d’extinction.

« Avec Co-LLM, nous formons un LLM généraliste à ‘appeler’ un modèle expert en cas de besoin », explique Shannon Shen, doctorante au MIT en génie électrique et informatique et affiliée au CSAIL, auteur principal d’un nouvel article sur l’approche. « Nous utilisons des données spécifiques à un domaine pour enseigner au modèle généraliste l’expertise de son homologue dans des domaines tels que les tâches biomédicales et les questions de mathématiques et de raisonnement. Ce processus identifie automatiquement les parties des données difficiles à générer pour le modèle généraliste, puis demande à ce dernier de passer au LLM expert, pré-entraîné sur des données similaires. Le modèle généraliste assure la génération de base, et lorsqu’il fait appel au LLM spécialisé, il invite l’expert à générer les tokens souhaités. Nos résultats montrent que les LLM apprennent à collaborer de manière organique, semblable à la façon dont les humains consultent des experts pour combler les lacunes.

Une combinaison de flexibilité et de réalité

Imaginez demander à un LLM généraliste de nommer les ingrédients d’un médicament spécifique. Il pourrait répondre incorrectement, nécessitant l’expertise d’un modèle spécialisé.

Pour démontrer la flexibilité de Co-LLM, les chercheurs ont utilisé des données telles que l’ensemble médical BioASQ pour coupler un LLM généraliste avec des LLM experts dans différents domaines, comme le Modèle Méditron, pré-entraîné sur des données médicales non étiquetées. Cela a permis à l’algorithme de répondre à des questions que recevrait typiquement un expert biomédical, comme les mécanismes à l’origine d’une maladie particulière.

Par exemple, si vous demandez à un LLM généraliste de nommer les ingrédients d’un médicament sur ordonnance, il pourrait se tromper. Avec l’expertise d’un modèle spécialisé en données biomédicales, vous obtiendrez une réponse plus précise. Co-LLM avertit également les utilisateurs des réponses à vérifier.

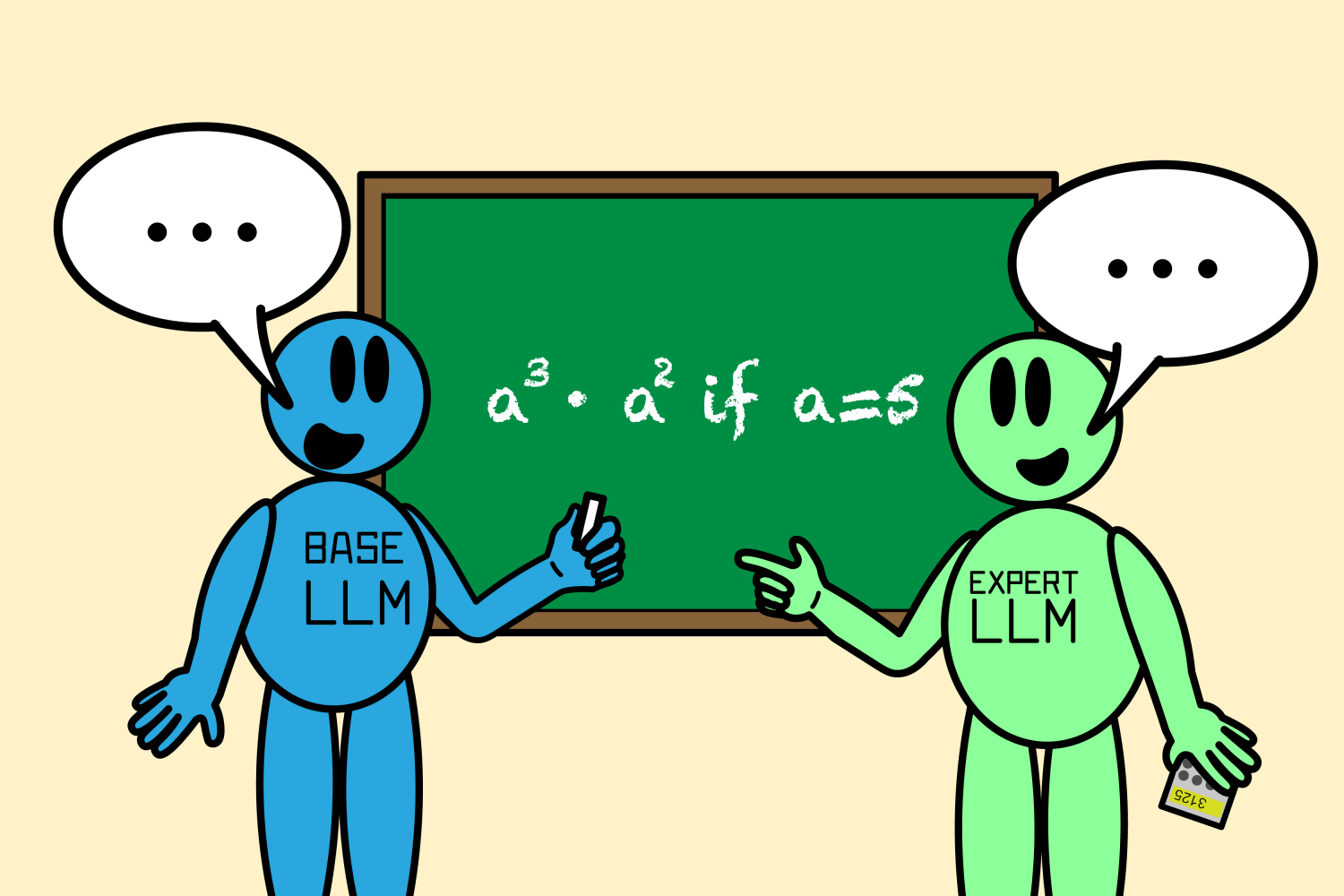

Un autre exemple de l’amélioration des performances de Co-LLM : lorsqu’il est chargé de résoudre un problème mathématique tel que « a3 · a2 si a=5 », le modèle généraliste a calculé incorrectement que la réponse était 125. En collaborant avec un grand LLM en mathématiques appelé Llemme, ils ont déterminé que la bonne solution était 3 125.

Le Co-LLM a fourni des réponses plus précises que les LLM simples et les modèles spécialisés non réglés fonctionnant indépendamment. Co-LLM peut guider deux modèles formés différemment à travailler ensemble, contrairement à d’autres approches de collaboration LLM efficaces, telles que le «Réglage du proxy», qui nécessitent que tous leurs modèles de composants soient formés de la même manière. De plus, cette méthode nécessite que chaque modèle soit utilisé simultanément pour produire la réponse, alors que l’algorithme du MIT active simplement son modèle expert pour des tokens spécifiques, rendant la génération plus efficace.

Quand demander à l’expert

L’algorithme des chercheurs du MIT montre qu’imiter le travail d’équipe humain peut augmenter la précision dans la collaboration multi-LLM. Pour améliorer encore sa précision factuelle, l’équipe envisage une approche de report plus robuste qui peut revenir en arrière lorsque le modèle expert ne donne pas de réponse correcte. Cette mise à niveau permettrait à Co-LLM de corriger sa trajectoire pour toujours fournir une réponse satisfaisante.

L’équipe souhaite également mettre à jour le modèle expert (via la formation du modèle généraliste) lorsque de nouvelles informations sont disponibles, gardant les réponses aussi actuelles que possible. Cela permettrait à Co-LLM d’associer les informations les plus récentes à un fort pouvoir de raisonnement. À terme, le modèle pourrait aider avec les documents d’entreprise, en utilisant les dernières informations pour les mettre à jour en conséquence. Co-LLM pourrait également former de petits modèles privés à travailler avec un LLM plus puissant pour améliorer les documents qui doivent rester sur le serveur.

« Le Co-LLM présente une approche intéressante pour apprendre à choisir entre deux modèles afin d’améliorer l’efficacité et les performances », explique Colin Raffel, professeur agrégé à l’Université de Toronto et directeur de recherche associé au Vector Institute, qui n’a pas participé à l’étude. « Étant donné que les décisions de routage sont prises au niveau du jeton, Co-LLM fournit un moyen granulaire de reporter les étapes de génération difficiles vers un modèle plus puissant. La combinaison unique de routage au niveau du modèle et du jeton offre également une grande flexibilité qui manque à des méthodes similaires. Co-LLM contribue à un axe de travail important qui vise à développer des écosystèmes de modèles spécialisés pour surpasser les systèmes d’IA monolithiques coûteux.

Shen a rédigé l’article avec quatre autres affiliés du CSAIL : le doctorant Hunter Lang ’17, MEng ’18 ; Bailin Wang, ancien postdoctorant et chercheur Apple AI/ML ; Yoon Kim, professeur adjoint de génie électrique et d’informatique au MIT, et David Sontag PhD ’10, professeur et membre de la Jameel Clinic, font tous deux partie du MIT-IBM Watson AI Lab. Leurs recherches ont été soutenues, en partie, par la National Science Foundation, la bourse NDSEG (National Defence Science and Engineering Graduate), le MIT-IBM Watson AI Lab et Amazon. Leurs travaux ont été présentés lors de la réunion annuelle de l’Association for Computational Linguistics.