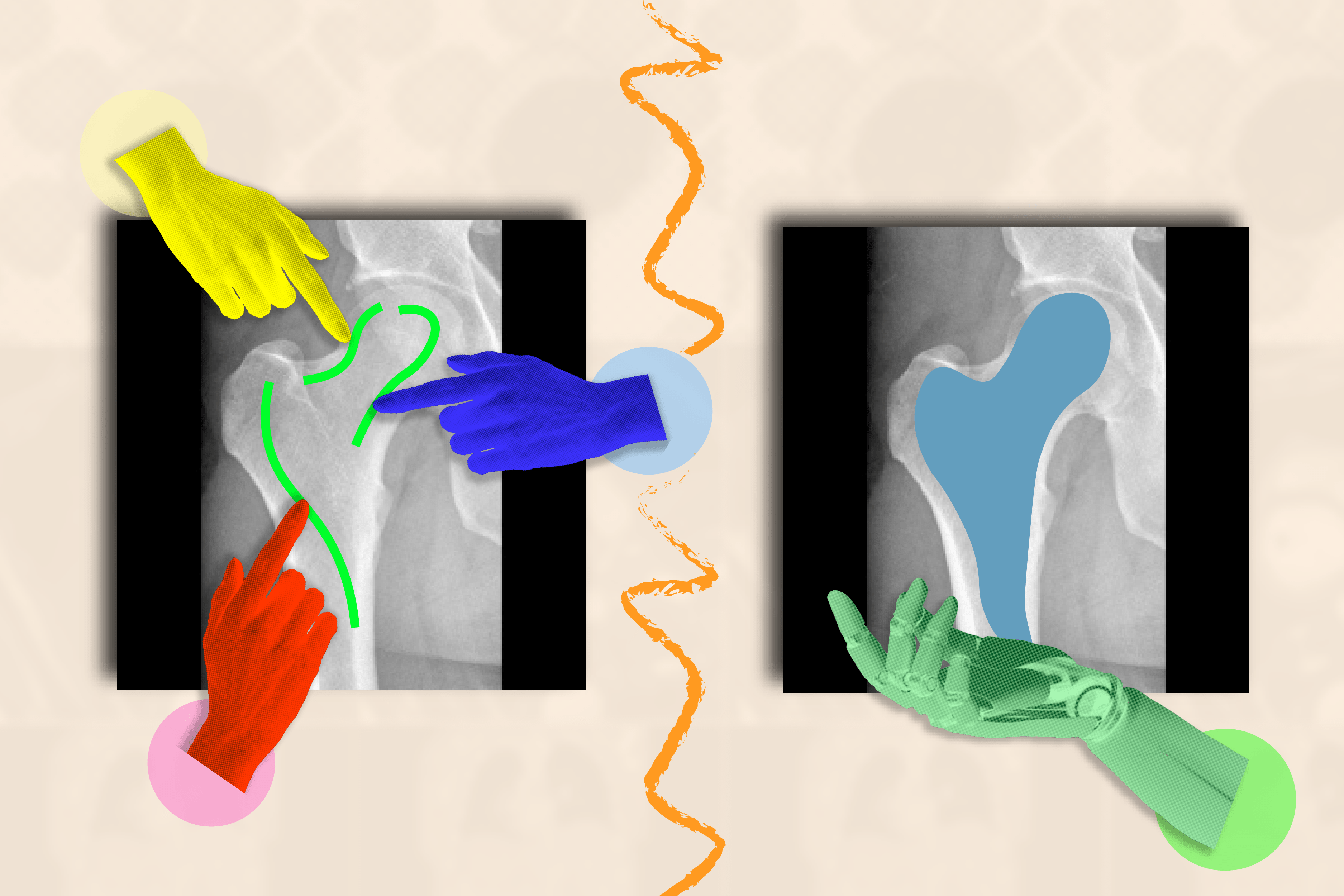

Pour un œil non averti, une image médicale telle qu’une IRM ou une radiographie peut sembler être une collection confuse de taches en noir et blanc. Il est souvent difficile de distinguer où une structure (comme une tumeur) se termine et où une autre commence.

Les systèmes d’IA, lorsqu’ils sont formés à comprendre les limites des structures biologiques, peuvent segmenter (ou délimiter) les régions d’intérêt que les médecins et les professionnels biomédicaux souhaitent surveiller pour détecter des maladies et autres anomalies. Plutôt que de perdre un temps précieux à tracer manuellement l’anatomie sur de nombreuses images, un assistant artificiel pourrait accomplir cette tâche à leur place.

Le problème ? Les chercheurs et les cliniciens doivent annoter d’innombrables images pour entraîner leur système d’IA avant qu’il puisse segmenter avec précision. Par exemple, il faudrait annoter le cortex cérébral dans de nombreuses IRM pour former un modèle supervisé capable de comprendre comment la forme du cortex peut varier d’un cerveau à l’autre.

Pour éviter cette collecte de données fastidieuse, des chercheurs du laboratoire d’informatique et d’intelligence artificielle (CSAIL) du MIT, du Massachusetts General Hospital (MGH) et de la Harvard Medical School ont développé un système interactif appelé «ScribblePrompt» : un outil flexible qui peut aider à segmenter rapidement n’importe quelle image médicale, même celles qu’il n’a jamais vues auparavant.

Au lieu de laisser des humains annoter chaque image manuellement, l’équipe a simulé la manière dont les utilisateurs annoteraient plus de 50 000 scans, y compris des IRM, des échographies et des photographies, sur des structures telles que les yeux, les cellules, le cerveau, les os, la peau, etc. Pour étiqueter toutes ces analyses, l’équipe a utilisé des algorithmes pour simuler la façon dont les humains gribouilleraient et cliqueraient sur différentes régions des images médicales. En plus des régions couramment étiquetées, l’équipe a également utilisé des algorithmes de superpixels, qui identifient des parties de l’image avec des valeurs similaires, pour découvrir de nouvelles régions d’intérêt potentielles pour les chercheurs en médecine et entraîner ScribblePrompt à les segmenter. Ces données synthétiques ont préparé ScribblePrompt à gérer les demandes de segmentation réelles des utilisateurs.

« L’IA a un potentiel significatif dans l’analyse d’images et d’autres données de grande dimension pour aider les humains à être plus productifs », déclare Hallee Wong SM ’22, doctorante au MIT, auteur principal d’une étude récente sur ScribblePrompt et affiliée au CSAIL. « Nous voulons augmenter, et non remplacer, les efforts du personnel médical grâce à un système interactif. ScribblePrompt est un modèle simple et efficace pour aider les médecins à se concentrer sur les parties les plus intéressantes de leur analyse. Il est plus rapide et plus précis que les méthodes de segmentation interactive comparables, réduisant le temps d’annotation de 28 % par rapport au cadre Segment Anything Model (SAM) de Meta, par exemple.

L’interface de ScribblePrompt est simple : les utilisateurs peuvent gribouiller sur la zone brute qu’ils souhaitent segmenter, ou cliquer dessus, et l’outil mettra en évidence toute la structure ou l’arrière-plan comme demandé. Par exemple, vous pouvez cliquer sur des veines individuelles dans un scan de la rétine (œil). ScribblePrompt peut également baliser une structure en fonction d’un cadre de délimitation.

Ensuite, l’outil peut apporter des corrections en fonction des retours de l’utilisateur. Si vous souhaitez mettre en évidence un rein lors d’une échographie, vous pouvez utiliser un cadre de délimitation, puis gribouiller des parties supplémentaires de la structure si ScribblePrompt manque des bords. Si vous souhaitez modifier votre segment, vous pouvez utiliser un « gribouillage négatif » pour exclure certaines régions.

Ces capacités interactives et autocorrectrices ont fait de ScribblePrompt l’outil préféré des chercheurs en neuroimagerie du MGH dans le cadre d’une étude sur les utilisateurs. 93,8 % de ces utilisateurs ont privilégié l’approche MIT par rapport à la base de référence SAM pour améliorer ses segments en réponse aux corrections de gribouillis. En ce qui concerne les modifications par clic, 87,5 % des chercheurs en médecine ont préféré ScribblePrompt.

ScribblePrompt a été formé sur des gribouillis et des clics simulés sur 54 000 images réparties dans 65 ensembles de données, comprenant des analyses des yeux, du thorax, de la colonne vertébrale, des cellules, de la peau, des muscles abdominaux, du cou, du cerveau, des os, des dents et des lésions. Le modèle s’est familiarisé avec 16 types d’images médicales, notamment des microscopies, des tomodensitogrammes, des rayons X, des IRM, des échographies et des photographies.

« De nombreuses méthodes existantes ne répondent pas bien lorsque les utilisateurs gribouillent sur des images, car il est difficile de simuler de telles interactions lors de la formation. Pour ScribblePrompt, nous avons pu forcer notre modèle à prêter attention à différentes entrées à l’aide de nos tâches de segmentation synthétique », explique Wong. « Nous voulions former ce qui est essentiellement un modèle de base sur un grand nombre de données diverses afin qu’il puisse se généraliser à de nouveaux types d’images et de tâches. »

Après avoir collecté autant de données, l’équipe a évalué ScribblePrompt sur 12 nouveaux ensembles de données. Bien qu’il n’ait jamais vu ces images auparavant, il a surpassé quatre méthodes existantes en segmentant plus efficacement et en donnant des prédictions plus précises sur les régions exactes que les utilisateurs souhaitaient mettre en évidence.

« La segmentation est la tâche d’analyse d’images biomédicales la plus répandue, largement réalisée à la fois dans la pratique clinique de routine et dans la recherche, ce qui la rend à la fois très diversifiée et constitue une étape cruciale et impactante », déclare l’auteur principal Adrian Dalca SM ’12, PhD. ’16, chercheur scientifique du CSAIL et professeur adjoint au MGH et à la Harvard Medical School. « ScribblePrompt a été soigneusement conçu pour être utile dans la pratique aux cliniciens et aux chercheurs, et donc pour rendre cette étape beaucoup plus rapide. »

« La majorité des algorithmes de segmentation développés dans le domaine de l’analyse d’images et de l’apprentissage automatique reposent au moins dans une certaine mesure sur notre capacité à annoter manuellement les images », explique Bruce Fischl, professeur de radiologie à la Harvard Medical School et neuroscientifique au MGH, qui n’a pas participé à l’étude. « Le problème est considérablement pire dans l’imagerie médicale dans laquelle nos « images » sont généralement des volumes 3D, car les êtres humains n’ont aucune raison évolutive ou phénoménologique d’avoir la moindre compétence dans l’annotation d’images 3D. ScribblePrompt permet d’effectuer des annotations manuelles beaucoup plus rapidement et avec plus de précision, en entraînant un réseau précisément sur les types d’interactions qu’un humain aurait généralement avec une image lors d’une annotation manuelle. Le résultat est une interface intuitive qui permet aux annotateurs d’interagir naturellement avec les données d’imagerie avec une productivité bien supérieure à ce qui était possible auparavant.

Wong et Dalca ont rédigé l’article avec deux autres affiliés du CSAIL : John Guttag, professeur Dugald C. Jackson d’EECS au MIT et chercheur principal du CSAIL ; et Marianne Rakic SM ’22, doctorante au MIT. Leurs travaux ont été soutenus, en partie, par Quanta Computer Inc., le Centre Eric et Wendy Schmidt du Broad Institute, le Wistron Corp. et le National Institute of Biomedical Imaging and Bioengineering des National Institutes of Health, avec le soutien matériel du Centre des sciences de la vie du Massachusetts.

Les travaux de Wong et de ses collègues seront présentés à la Conférence européenne 2024 sur la vision par ordinateur et ont été présentés sous forme d’exposé oral lors de l’atelier DCAMI de la conférence sur la vision par ordinateur et la reconnaissance de formes plus tôt cette année. Ils ont reçu le Bench-to-Bedside Paper Award lors de l’atelier pour l’impact clinique potentiel de ScribblePrompt.