Image par auteur

Les grands modèles linguistiques ont révolutionné le domaine du traitement du langage naturel, offrant des capacités sans précédent dans des tâches telles que la traduction linguistique, l’analyse des sentiments et la génération de texte.

Cependant, la formation de tels modèles prend du temps et coûte cher. C’est pourquoi le réglage fin est devenu une étape cruciale pour adapter ces algorithmes avancés à des tâches ou des domaines spécifiques.

Juste pour nous assurer que nous sommes sur la même longueur d’onde, nous devons rappeler deux concepts :

- Modèles de langage pré-entraînés

- Réglage fin

Décomposons donc ces deux concepts.

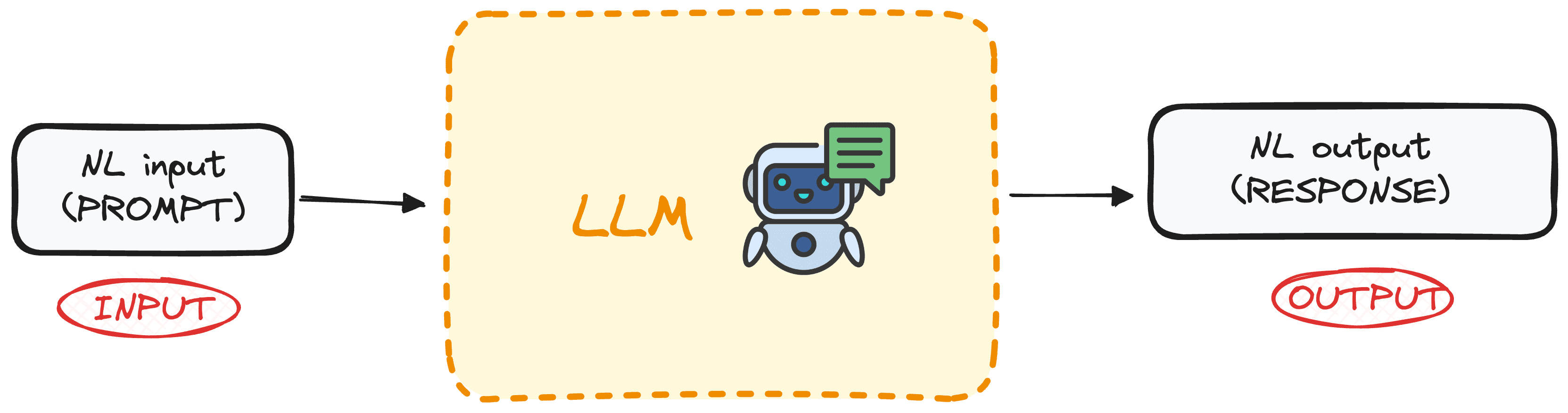

Qu’est-ce qu’un grand modèle de langage pré-entraîné ?

Les LLM sont une catégorie spécifique d’apprentissage automatique destinée à prédire le mot suivant dans une séquence en fonction du contexte fourni par les mots précédents. Ces modèles sont basés sur l’architecture Transformers et sont formés sur de nombreuses données textuelles, leur permettant de comprendre et de générer du texte de type humain.

Le meilleur de cette nouvelle technologie est sa démocratisation, car la plupart de ces modèles sont sous licence open source ou sont accessibles via des API à faible coût.

Image par auteur

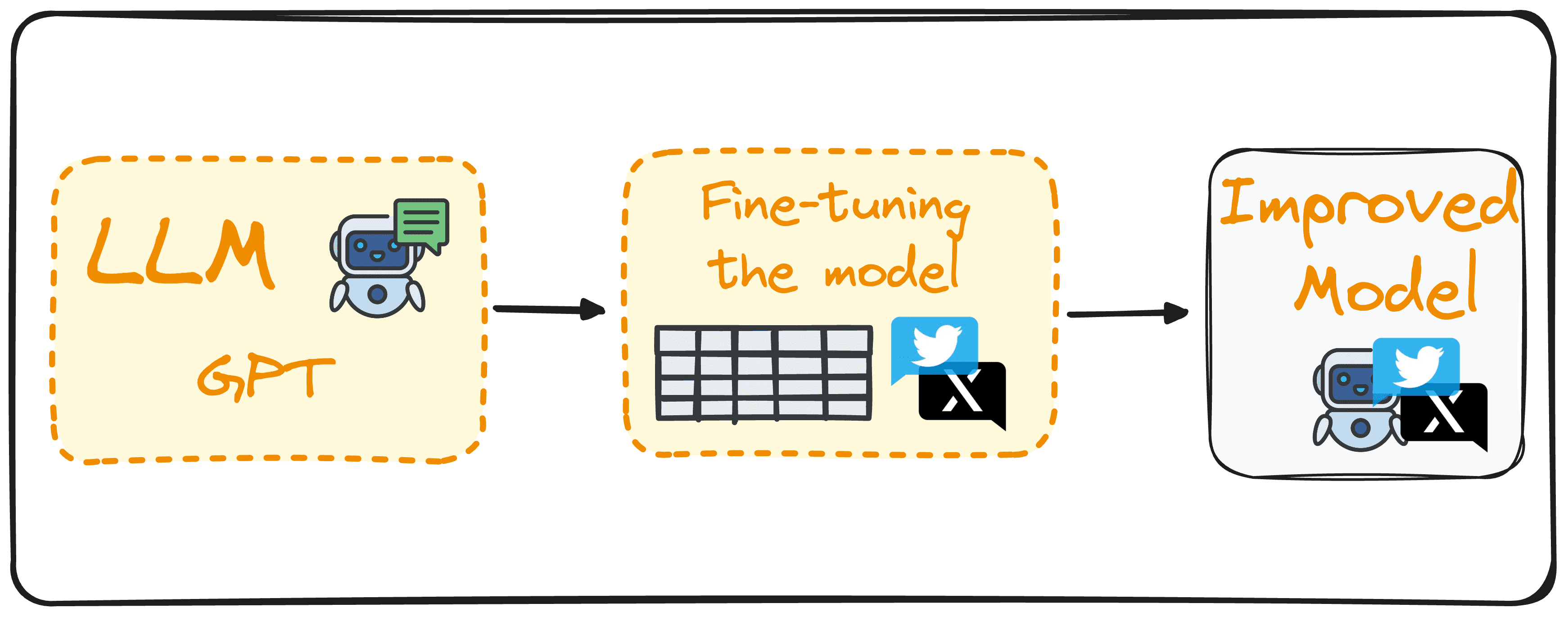

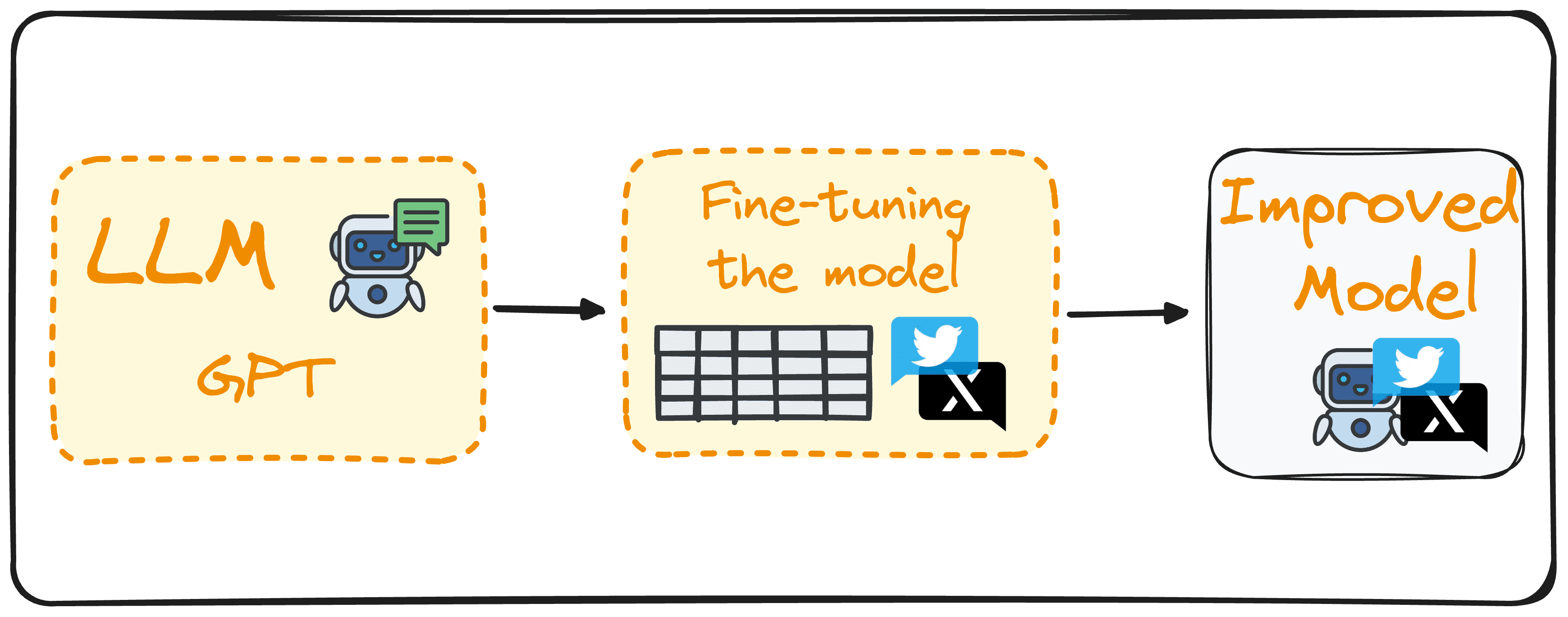

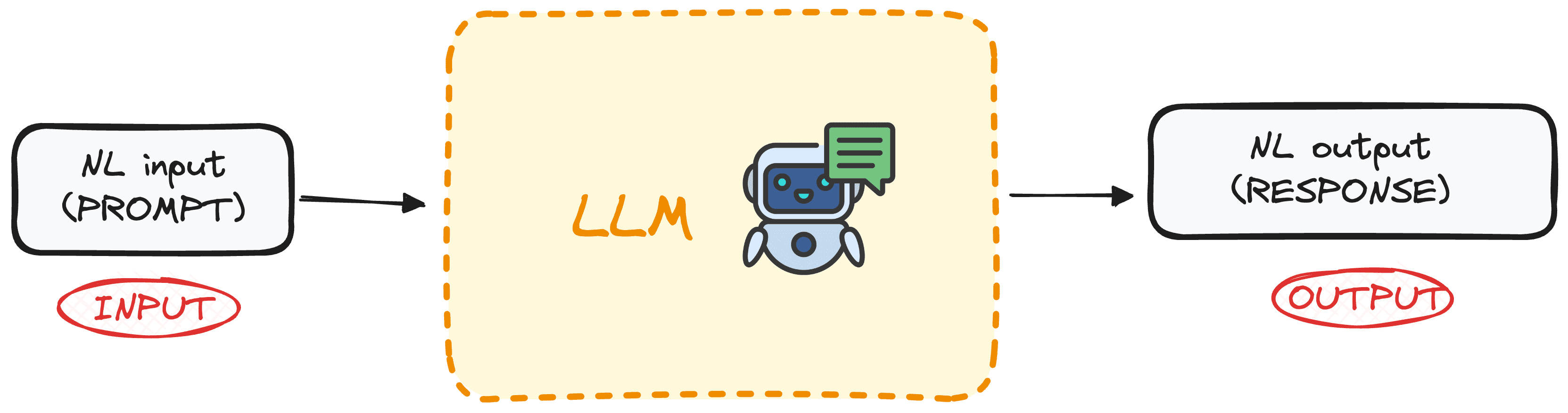

Qu’est-ce que le réglage fin ?

Le réglage fin implique d’utiliser un modèle de langage étendu comme base et de le former davantage avec un ensemble de données basé sur un domaine pour améliorer ses performances sur des tâches spécifiques.

Prenons comme exemple un modèle permettant de détecter les sentiments dans les tweets. Au lieu de créer un nouveau modèle à partir de zéro, nous pourrions tirer parti des capacités de langage naturel de GPT-3 et le former davantage avec un ensemble de données de tweets étiquetés avec leur sentiment correspondant.

Cela améliorerait ce modèle dans notre tâche spécifique de détection des sentiments à partir des tweets.

Ce processus réduit les coûts de calcul, élimine le besoin de développer de nouveaux modèles à partir de zéro et les rend plus efficaces pour des applications réelles adaptées à des besoins et objectifs spécifiques.

Image par auteur

Alors maintenant que nous connaissons les bases, vous pouvez apprendre à affiner votre modèle en suivant ces 7 étapes.

Diverses approches de réglage fin

Le réglage fin peut être mis en œuvre de différentes manières, chacune étant adaptée à des objectifs et des priorités spécifiques.

Mise au point supervisée

Cette méthode courante consiste à entraîner le modèle sur un ensemble de données étiqueté pertinent pour une tâche spécifique, comme la classification de texte ou la reconnaissance d’entités nommées. Par exemple, un modèle pourrait être formé sur des textes étiquetés avec des sentiments pour des tâches d’analyse des sentiments.

Apprentissage en quelques coups

Dans les situations où il n’est pas possible de rassembler un grand ensemble de données étiquetées, l’apprentissage en quelques étapes entre en jeu. Cette méthode utilise seulement quelques exemples pour donner au modèle un contexte de la tâche, évitant ainsi le besoin d’un réglage fin approfondi.

Apprentissage par transfert

Si toute mise au point est une forme d’apprentissage par transfert, cette catégorie spécifique est conçue pour permettre à un modèle d’aborder une tâche différente de sa formation initiale. Il utilise les vastes connaissances acquises à partir d’un ensemble de données générales et les applique à une tâche plus spécialisée ou connexe.

Ajustement spécifique au domaine

Cette approche se concentre sur la préparation du modèle pour comprendre et générer du texte pour une industrie ou un domaine spécifique. En affinant le modèle sur le texte d’un domaine ciblé, il obtient un meilleur contexte et une meilleure expertise dans les tâches spécifiques au domaine. Par exemple, un modèle peut être formé sur des dossiers médicaux pour adapter un chatbot spécifiquement à une application médicale.

Meilleures pratiques pour un réglage fin efficace

Pour effectuer un réglage fin réussi, certaines pratiques clés doivent être prises en compte.

Qualité et quantité des données

Les performances d’un modèle lors du réglage fin dépendent grandement de la qualité de l’ensemble de données utilisé. Gardez toujours à l’esprit :

Déchets entrants, déchets sortants.

Par conséquent, il est crucial d’utiliser des ensembles de données propres, pertinents et suffisamment volumineux pour la formation.

Réglage des hyperparamètres

La mise au point est un processus itératif qui nécessite souvent des ajustements. Expérimentez avec différents taux d’apprentissage, tailles de lots et durées de formation pour trouver la configuration optimale pour votre projet.

Un réglage précis est essentiel pour un apprentissage efficace et une adaptation aux nouvelles données, contribuant ainsi à éviter le surapprentissage.

Évaluation régulière

Surveillez en permanence les performances du modèle tout au long du processus de formation à l’aide d’un ensemble de données de validation distinct.

Cette évaluation régulière permet de suivre les performances du modèle sur la tâche prévue et de vérifier tout signe de surajustement. Des ajustements doivent être effectués sur la base de ces évaluations pour affiner efficacement les performances du modèle.

Naviguer dans les pièges du réglage fin du LLM

Ce processus peut conduire à des résultats insatisfaisants si certains écueils ne sont pas également évités :

Surapprentissage

Entraîner le modèle avec un petit ensemble de données ou subir trop d’époques peut conduire à un surajustement. Cela fait que le modèle fonctionne bien sur les données d’entraînement, mais mal sur les données invisibles, et a donc une faible précision pour les applications du monde réel.

Sous-ajustement

Cela se produit lorsque la formation est trop brève ou que le taux d’apprentissage est trop faible, ce qui donne lieu à un modèle qui n’apprend pas la tâche de manière efficace. Cela produit un modèle qui ne sait pas comment atteindre notre objectif spécifique.

Oubli catastrophique

Lorsqu’on peaufine un modèle sur une tâche spécifique, il existe un risque que le modèle oublie les vastes connaissances dont il disposait à l’origine. Ce phénomène, connu sous le nom d’oubli catastrophique, réduit l’efficacité du modèle dans diverses tâches, notamment lorsqu’il s’agit de compétences en langage naturel.

Fuite de données

Assurez-vous que vos ensembles de données de formation et de validation sont complètement séparés pour éviter les fuites de données. Les ensembles de données qui se chevauchent peuvent faussement gonfler les mesures de performances, donnant une mesure inexacte de l’efficacité du modèle.

Réflexions finales et étapes futures

Lancer le processus de réglage fin des grands modèles de langage présente une énorme opportunité d’améliorer l’état actuel des modèles pour des tâches spécifiques.

En comprenant et en mettant en œuvre les concepts détaillés, les meilleures pratiques et les précautions nécessaires, vous pouvez réussir à personnaliser ces modèles robustes pour répondre à des exigences spécifiques, exploitant ainsi pleinement leurs capacités.

Joseph Ferrer est un ingénieur analytique de Barcelone. Il est diplômé en ingénierie physique et travaille actuellement dans le domaine de la science des données appliquée à la mobilité humaine. Il est créateur de contenu à temps partiel axé sur la science et la technologie des données. Josep écrit sur tout ce qui concerne l’IA, couvrant l’application de l’explosion en cours dans ce domaine.