Jerone Andrews, Dora Zhao, Orestis Papakyriakopoulos et Alice Xiang ont remporté le prix du meilleur article à la Conférence internationale sur l’apprentissage automatique (ICML) pour leur article intitulé Mesurez la diversité des ensembles de données. Ne vous contentez pas de le réclamer. Nous avons discuté avec Jerone de la méthodologie de l’équipe et de la manière dont elle a développé un cadre pour conceptualiser, opérationnaliser et évaluer la diversité des ensembles de données d’apprentissage automatique.

Pourriez-vous nous donner un résumé de votre article : de quoi parle-t-il et quel est le problème que vous essayez de résoudre ?

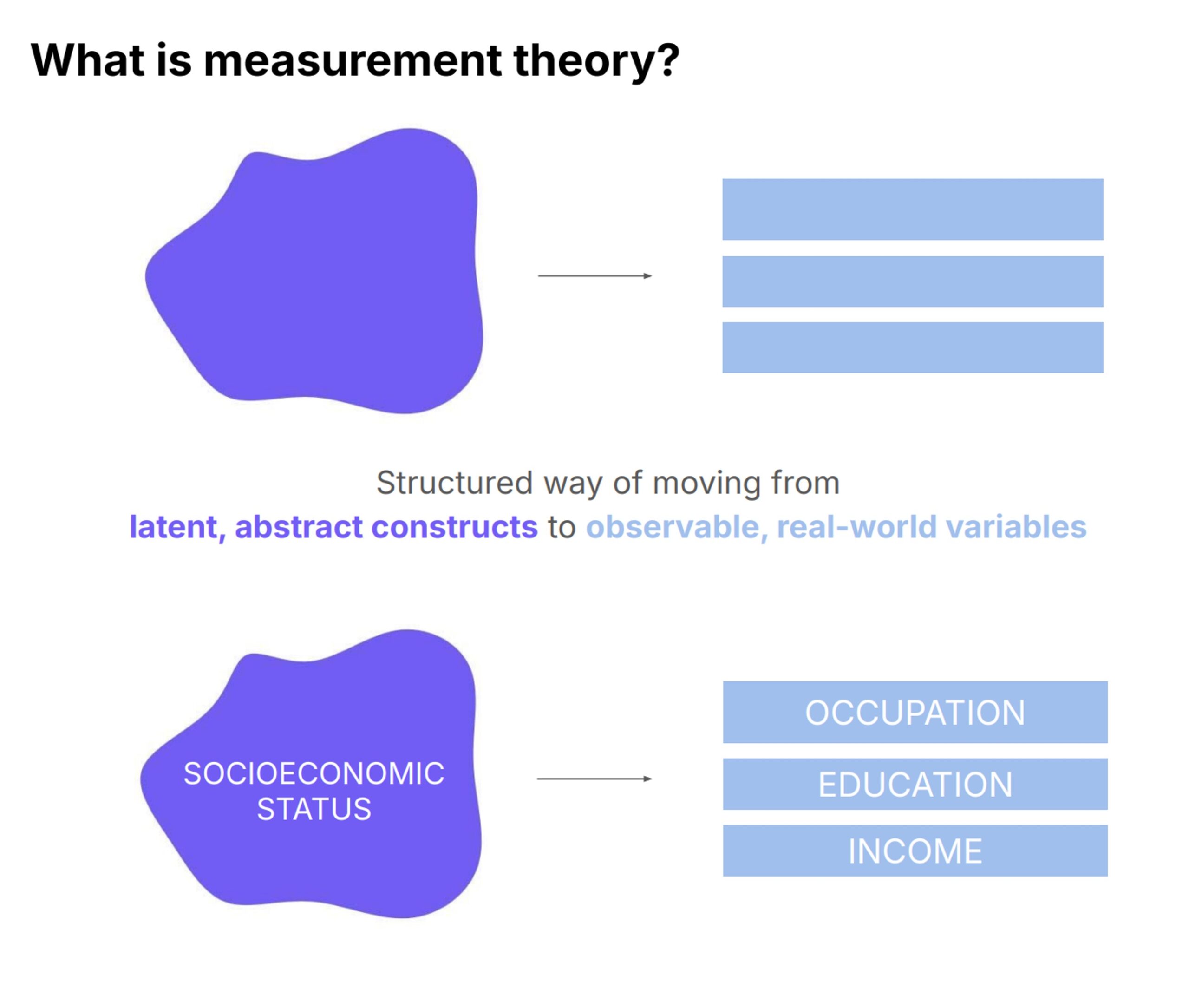

Dans notre article, nous proposons d’utiliser la théorie de la mesure des sciences sociales comme cadre pour améliorer la collecte et l’évaluation de divers ensembles de données d’apprentissage automatique. La théorie de la mesure offre une approche systématique et scientifiquement fondée pour développer des représentations numériques précises de concepts complexes et abstraits, ce qui la rend particulièrement adaptée aux tâches telles que la conceptualisation, l’opérationnalisation et l’évaluation de qualités telles que la diversité des ensembles de données. Ce cadre peut également être appliqué à d’autres concepts comme le biais ou la difficulté.

Nous avons identifié un problème important dans le domaine : le concept de diversité dans les ensembles de données est souvent mal défini ou appliqué de manière incohérente dans les différents travaux. Pour explorer cela, nous avons examiné 135 articles sur les ensembles de données d’apprentissage automatique, couvrant les ensembles de données texte, image et multimodaux (texte et image). Même si ces articles affirmaient souvent que leurs ensembles de données étaient plus diversifiés, nous avons constaté que le terme « diversité » était rarement clairement défini ou mesuré de manière cohérente.

Notre article plaide pour l’intégration de la théorie de la mesure dans le processus de collecte de données. Ce faisant, les créateurs d’ensembles de données peuvent mieux conceptualiser des concepts abstraits tels que la diversité, traduire ces concepts en indicateurs empiriques mesurables (tels que le nombre de pays représentés dans un ensemble de données sur la diversité géographique) et évaluer la fiabilité et la validité de leurs ensembles de données. Cette approche conduit finalement à une recherche plus transparente et reproductible en apprentissage automatique.

Théorie de la mesure. Crédit image : Jerone Andrews.

Théorie de la mesure. Crédit image : Jerone Andrews.

Pourriez-vous expliquer la conceptualisation, l’opérationnalisation et l’évaluation dans ce contexte ?

La conceptualisation implique de définir clairement les construits que l’on souhaite mesurer, en utilisant des termes précis et convenus. Par exemple, si nous visons la diversité en termes d’ethnicité, nous devons préciser exactement ce que nous entendons par ethnicité, car elle peut varier considérablement en fonction des contextes culturels et géographiques.

L’opérationnalisation est le processus de traduction de ces constructions abstraites en quelque chose qui peut être mesuré empiriquement. Par exemple, si nous traitons de race et que notre ensemble de données provient d’Internet, il peut être difficile de déduire directement la race d’une personne. Au lieu de cela, on pourrait utiliser un proxy, tel que le teint, qui peut être opérationnalisé lors de la collecte ou de l’étiquetage des données.

Nous divisons l’évaluation en deux : la fiabilité et la validité. La fiabilité vise à garantir que les mesures sont cohérentes et fiables. Cela peut impliquer des méthodes telles que la fiabilité test-retest, où nous pourrions collecter des données sur Twitter aujourd’hui, puis à nouveau la semaine prochaine en utilisant les mêmes requêtes. En comparant les deux ensembles de données, nous pouvons évaluer la cohérence de notre méthodologie de collecte de données. La validité, quant à elle, consiste à déterminer si les mesures empiriques correspondent aux constructions théoriques. Une approche pour y parvenir est la généralisation d’ensembles de données croisés. Par exemple, vous pouvez entraîner un modèle sur votre ensemble de données, puis le tester sur un autre ensemble de données similaire et préexistant. Si le modèle fonctionne de manière cohérente sur différents ensembles de données, cela suggère que la diversité capturée par votre ensemble de données est valide et généralisable, au moins par rapport à ce qui a été fait auparavant.

En quoi votre méthode s’appuie-t-elle sur des travaux antérieurs dans le domaine et en diffère-t-elle ?

Notre travail comble une lacune importante dans le domaine : l’absence d’une méthode convenue pour évaluer si un ensemble de données est réellement diversifié. Nous nous appuyons sur cela en introduisant un cadre issu des sciences sociales pour apporter plus de structure au processus d’évaluation.

C’est double. Premièrement, nous visons à fournir un cadre de principes que les chercheurs doivent suivre lors de la collecte d’ensembles de données, en garantissant que leurs affirmations sur la diversité soient étayées par des preuves concrètes. Deuxièmement, notre cadre est conçu pour les réviseurs d’articles sur l’apprentissage automatique qui doivent évaluer de manière critique les affirmations sur la diversité formulées dans ces articles. Contrairement aux modèles, où les normes d’évaluation sont rigoureuses et bien établies, les ensembles de données ne sont souvent pas soumis au même niveau d’examen. Cela conduit à de nombreux articles sur les ensembles de données revendiquant la diversité sans justification adéquate. Notre cadre est une réponse à cette incohérence, en soulignant que les affirmations concernant la diversité des ensembles de données doivent être étayées avec la même rigueur attendue dans les évaluations de modèles.

Dans le journal, vous réalisez une étude de cas. Pourriez-vous nous en parler un peu ?

L’étude de cas présentée dans notre article examine l’ensemble de données Segment Anything (SA-1B) de Meta, en mettant l’accent sur la manière dont ils abordent et mesurent la diversité au sein de l’ensemble de données. Nous avons analysé comment les créateurs ont opérationnalisé la diversité à travers diverses dimensions, telles que la diversité géographique, la taille et la complexité des objets. Par exemple, ils ont mesuré la complexité des masques de segmentation, qui sert d’indicateur de la diversité des formes d’objets. En comparant ces mesures à celles d’autres ensembles de données de segmentation, ils ont pu évaluer la diversité et la difficulté relatives de leur ensemble de données. Cette comparaison permet d’identifier si l’ensemble de données fournit une représentation équilibrée de différentes complexités ou s’il est orienté vers des masques plus simples ou plus complexes. Grâce à cette analyse, nous avons illustré l’importance de définir et de mesurer clairement la diversité pour garantir que les ensembles de données reflètent véritablement la diversité qu’ils prétendent représenter.

Si vous deviez appeler la communauté avec des recommandations et des éléments à prendre en compte lorsqu’elle mène ses recherches, que diriez-vous ?

Les défis auxquels nous sommes confrontés en matière de diversité des ensembles de données ne relèvent pas uniquement de la responsabilité des collecteurs ou des réviseurs d’ensembles de données ; ils sont symptomatiques de la culture de recherche plus large. Souvent, les résultats négatifs sont sous-estimés et les analyses critiques, telles que les comparaisons ou les graphiques détaillés, peuvent être négligées car elles pourraient jeter un article sous un jour moins favorable. Mon appel à l’action est pour que la communauté des chercheurs déplace l’attention du processus d’examen des articles sur les ensembles de données du simple produit final vers l’ensemble du processus suivi par les auteurs. Actuellement, on accorde trop d’importance aux résultats finaux, ce qui conduit à la publication d’ensembles de données affirmant une plus grande diversité basée uniquement sur de meilleures performances du modèle. Cependant, de meilleures performances ne sont pas nécessairement synonymes d’une véritable diversité ; cela pourrait signifier qu’un ensemble de données « plus diversifié » récemment proposé a introduit des corrélations plus parasites, permettant aux modèles de prendre des raccourcis plutôt que de refléter véritablement des données diverses.

Notre article souligne également l’importance de reconnaître que la diversité ne réduit pas automatiquement les biais, et que le fait d’avoir plus de données ne rend pas intrinsèquement un modèle moins biaisé ou un ensemble de données plus diversifié. Un ensemble de données plus vaste pourrait accroître la diversité de composition en incluant une plus grande variété d’éléments ou de concepts, mais il pourrait également introduire de nouvelles corrélations parasites. Il est crucial de faire la différence entre des concepts tels que la diversité, les préjugés et l’échelle, et de comprendre que la réalisation de l’un ne signifie pas automatiquement la réalisation des autres.

À propos de Jerone

| Jerone Andrews est chercheur scientifique chez Sony AI. Son travail se concentre sur la conservation responsable des données, l’apprentissage des représentations ainsi que la détection et l’atténuation des biais. Jerone est titulaire d’une maîtrise en mathématiques du King’s College de Londres, suivie d’un MRes financé par l’EPSRC et d’un doctorat en informatique de l’University College de Londres. Sa carrière de chercheur comprend une bourse de recherche de la Royal Academy of Engineering et une bourse de recherche médiatique de la British Science Association avec BBC Future. De plus, Jerone a été chercheur invité à l’Institut national d’informatique de Tokyo et à Telefónica Research à Barcelone. |

Lucy Smith, rédactrice en chef d’AIhub.