Supposons que vous souhaitiez former un robot afin qu’il comprenne comment utiliser les outils et qu’il puisse ensuite apprendre rapidement à effectuer des réparations dans votre maison avec un marteau, une clé et un tournevis. Pour ce faire, vous auriez besoin d’une énorme quantité de données démontrant l’utilisation des outils.

Les ensembles de données robotiques existants varient considérablement en termes de modalités : certains incluent des images en couleur tandis que d’autres sont composés d’empreintes tactiles, par exemple. Les données pourraient également être collectées dans différents domaines, comme la simulation ou les démonstrations humaines. Et chaque ensemble de données peut capturer une tâche et un environnement uniques.

Il est difficile d’incorporer efficacement des données provenant d’autant de sources dans un seul modèle d’apprentissage automatique, tant de méthodes utilisent un seul type de données pour entraîner un robot. Mais les robots entraînés de cette manière, avec une quantité relativement faible de données spécifiques à une tâche, sont souvent incapables d’effectuer de nouvelles tâches dans des environnements inconnus.

Dans le but de former de meilleurs robots polyvalents, les chercheurs du MIT ont développé une technique permettant de combiner plusieurs sources de données dans différents domaines, modalités et tâches à l’aide d’un type d’IA générative appelé modèles de diffusion.

Ils entraînent un modèle de diffusion distinct pour apprendre une stratégie, ou une politique, permettant d’accomplir une tâche à l’aide d’un ensemble de données spécifique. Ensuite, ils combinent les politiques apprises par les modèles de diffusion en une politique générale qui permet à un robot d’effectuer plusieurs tâches dans divers contextes.

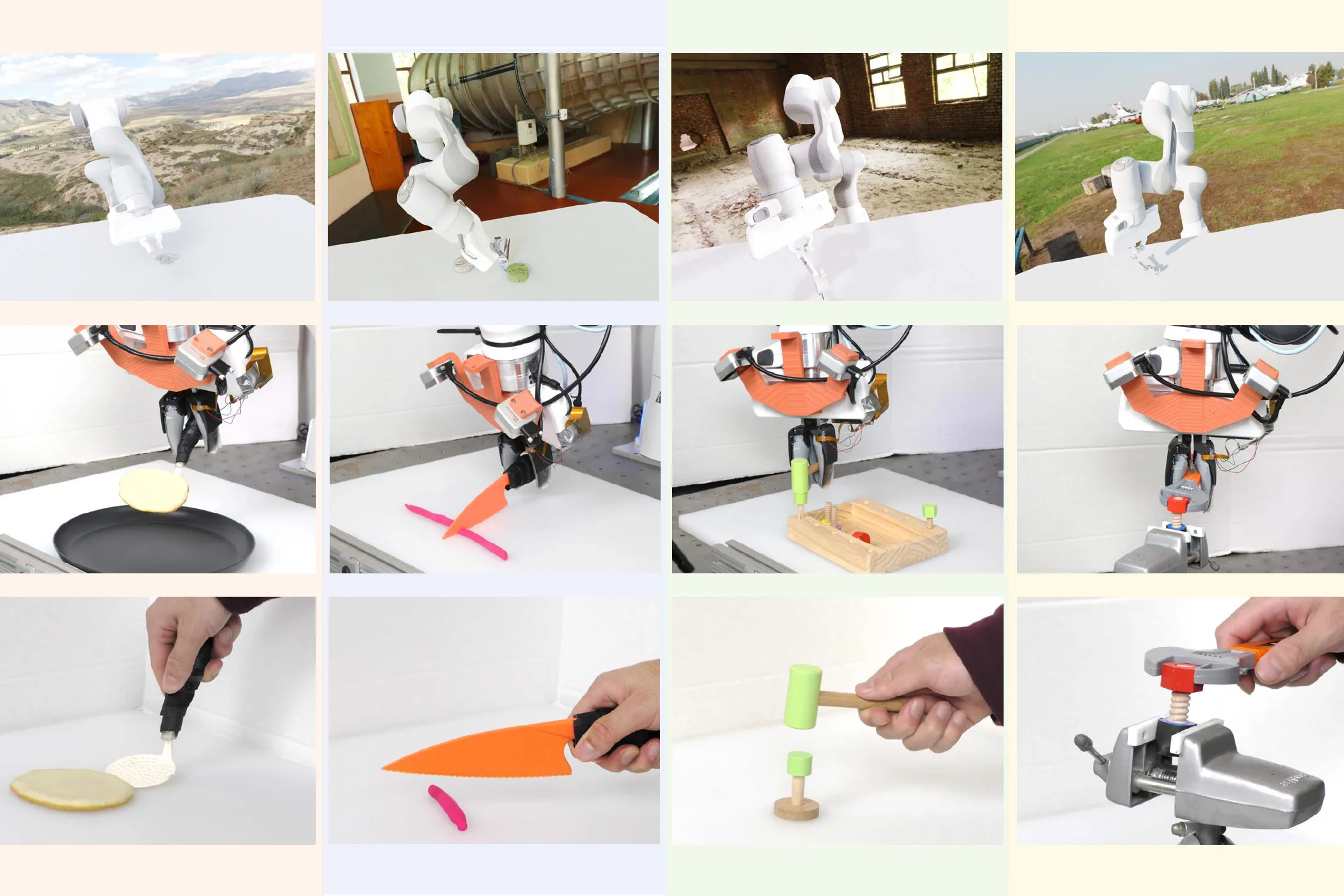

Dans les simulations et les expériences réelles, cette approche de formation a permis à un robot d’effectuer plusieurs tâches d’utilisation d’outils et de s’adapter à de nouvelles tâches qu’il n’avait pas vues pendant la formation. La méthode, connue sous le nom de Policy Composition (PoCo), a conduit à une amélioration de 20 % de la performance des tâches par rapport aux techniques de base.

« Aborder l’hétérogénéité dans les ensembles de données robotiques est comme un problème d’œuf de poule. Si nous voulons utiliser beaucoup de données pour former des politiques générales en matière de robots, nous avons d’abord besoin de robots déployables pour obtenir toutes ces données. Je pense que l’exploitation de toutes les données hétérogènes disponibles, à l’instar de ce que les chercheurs ont fait avec ChatGPT, est une étape importante pour le domaine de la robotique », déclare Lirui Wang, étudiante diplômée en génie électrique et informatique (EECS) et auteur principal d’une étude. article sur PoCo.

Les coauteurs de Wang incluent Jialiang Zhao, étudiant diplômé en génie mécanique ; Yilun Du, étudiante diplômée de l’EECS ; Edward Adelson, professeur John et Dorothy Wilson de sciences de la vision au Département des sciences du cerveau et des sciences cognitives et membre du Laboratoire d’informatique et d’intelligence artificielle (CSAIL) ; et l’auteur principal Russ Tedrake, professeur Toyota d’EECS, d’aéronautique et d’astronautique et de génie mécanique, et membre du CSAIL. La recherche sera présentée à la conférence Robotics: Science and Systems.

Combiner des ensembles de données disparates

Une politique robotique est un modèle d’apprentissage automatique qui prend des entrées et les utilise pour effectuer une action. Une façon de concevoir une politique est de la considérer comme une stratégie. Dans le cas d’un bras robotique, cette stratégie peut être une trajectoire ou une série de poses qui déplacent le bras pour qu’il prenne un marteau et l’utilise pour enfoncer un clou.

Les ensembles de données utilisés pour apprendre les politiques robotiques sont généralement petits et axés sur une tâche et un environnement particuliers, comme emballer des articles dans des cartons dans un entrepôt.

« Chaque entrepôt robotique génère des téraoctets de données, mais ceux-ci appartiennent uniquement à l’installation robotique spécifique travaillant sur ces packages. Ce n’est pas idéal si vous souhaitez utiliser toutes ces données pour entraîner une machine générale », explique Wang.

Les chercheurs du MIT ont développé une technique qui permet de prendre une série d’ensembles de données plus petits, comme ceux collectés dans de nombreux entrepôts robotiques, d’apprendre des politiques distinctes de chacun et de combiner les politiques de manière à permettre à un robot de se généraliser à de nombreuses tâches.

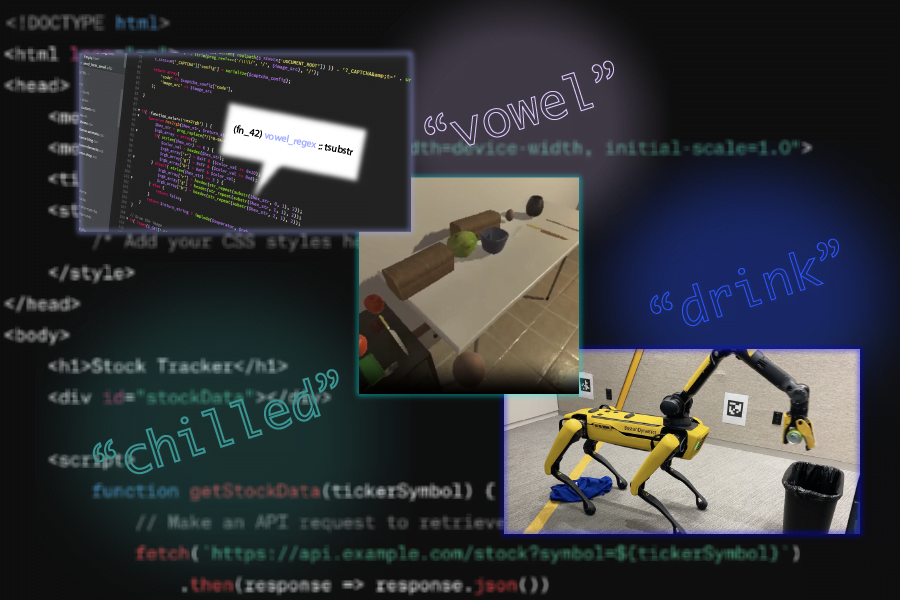

Ils représentent chaque politique à l’aide d’un type de modèle d’IA génératif appelé modèle de diffusion. Les modèles de diffusion, souvent utilisés pour la génération d’images, apprennent à créer de nouveaux échantillons de données qui ressemblent à des échantillons d’un ensemble de données d’entraînement en affinant leur sortie de manière itérative.

Mais plutôt que d’enseigner un modèle de diffusion pour générer des images, les chercheurs lui apprennent à générer une trajectoire pour un robot. Pour ce faire, ils ajoutent du bruit aux trajectoires dans un ensemble de données d’entraînement. Le modèle de diffusion supprime progressivement le bruit et affine sa sortie en une trajectoire.

Cette technique, connue sous le nom Politique de diffusion, a été précédemment présenté par des chercheurs du MIT, de l’Université de Columbia et du Toyota Research Institute. PoCo s’appuie sur ce travail de politique de diffusion.

L’équipe forme chaque modèle de diffusion avec un type différent d’ensemble de données, comme un avec des démonstrations vidéo humaines et un autre glané lors de la téléopération d’un bras robotique.

Ensuite, les chercheurs effectuent une combinaison pondérée des politiques individuelles apprises par tous les modèles de diffusion, affinant de manière itérative les résultats afin que la politique combinée satisfasse les objectifs de chaque politique individuelle.

Plus grand que la somme de ses parties

« L’un des avantages de cette approche est que nous pouvons combiner les politiques pour tirer le meilleur parti des deux mondes. Par exemple, une politique formée sur des données du monde réel pourrait être en mesure d’atteindre plus de dextérité, tandis qu’une politique formée sur la simulation pourrait être en mesure d’atteindre une plus grande généralisation », explique Wang.

Image : Avec l’aimable autorisation des chercheurs

Étant donné que les politiques sont formées séparément, on pourrait mélanger et assortir les politiques de diffusion pour obtenir de meilleurs résultats pour une tâche donnée. Un utilisateur peut également ajouter des données dans une nouvelle modalité ou un nouveau domaine en formant une politique de diffusion supplémentaire avec cet ensemble de données, plutôt que de recommencer l’ensemble du processus à partir de zéro.

Image : Avec l’aimable autorisation des chercheurs

Les chercheurs ont testé PoCo en simulation et sur de vrais bras robotiques qui effectuaient diverses tâches d’outils, telles que l’utilisation d’un marteau pour enfoncer un clou et retourner un objet avec une spatule. PoCo a entraîné une amélioration de 20 % de la performance des tâches par rapport aux méthodes de base.

« Ce qui est frappant, c’est que lorsque nous avons terminé le réglage et l’avons visualisé, nous pouvons clairement voir que la trajectoire composée est bien meilleure que l’une ou l’autre d’entre elles individuellement », explique Wang.

À l’avenir, les chercheurs souhaitent appliquer cette technique à des tâches à long terme dans lesquelles un robot prendrait un outil, l’utiliserait, puis passerait à un autre outil. Ils souhaitent également intégrer des ensembles de données robotiques plus volumineux pour améliorer les performances.

« Nous aurons besoin des trois types de données pour réussir en robotique : des données Internet, des données de simulation et des données réelles de robots. Comment les combiner efficacement sera la question à un million de dollars. PoCo est une étape solide sur la bonne voie », déclare Jim Fan, chercheur scientifique principal chez NVIDIA et leader de l’AI Agents Initiative, qui n’a pas participé à ce travail.

Cette recherche est financée en partie par Amazon, la Singapore Defence Science and Technology Agency, la National Science Foundation des États-Unis et le Toyota Research Institute.